Perplexity 推出的 Perplexity Computer 主打「多模型 AI 代理(agent)」:不只回答問題,而是能像數位員工一樣,在目標導向下拆解任務、呼叫不同模型與工具、跨系統完成一段工作流程。對企業而言,這件事的重要性不在於又多了一個聊天機器人,而是它把 AI 從「知識查詢」推進到「可交付成果的流程執行者」。 這篇文章會用企業落地的視角,拆解 Perplexity Computer 的核心概念、適合的工作型態、導入方法,以及你必須正視的風險與治理。 為什麼「多模型代理」比單一聊天更像數位員工? 企業在導入生成式 AI 的第一階段,多半停在:寫文案、整理會議紀錄、回覆客服草稿、做摘要。但一旦進入真實流程,你會遇到幾個卡點: 任務不是一句提示就結束:例如「整理競品情報並寄給團隊」包含查資料、比對可信來源、產出表格、寫郵件、附上引用與連結、寄送並留存紀錄。 不同步驟需要不同能力:檢索要可信、寫作要符合品牌語氣、資料整理要可追溯、最後還要能呼叫內部工具(CRM、工單系統、文件庫)。 單一模型很難同時兼顧:有的模型強在推理、有的強在程式、有的強在文字風格;企業追求的是「整體交付」而非某一次對話的驚艷。 多模型代理的價值在於:它把「選模型」變成系統自動決策的一部分,並把工具使用(瀏覽、檔案、表格、內部 API)納入一條可控的任務鏈。 Perplexity Computer...

不少團隊把 AI 寫程式的期待放在「更快產出」,但真正卡關的常是:需求拆解、跨檔案修改、測試與回歸、Code Review、以及安全邊界怎麼管。OpenAI Codex Windows 桌面應用程式的價值,正是在「把 AI 變成可協作的開發隊友」,並用多代理(multi-agent)分工把開發流程串起來,同時降低把機密與風險放進工具裡的顧慮。 以下以 Windows 桌面情境出發,整理它在多代理協作、日常開發工作流、與安全治理上你需要掌握的重點,並提供一套可立即套用的落地方式。 Codex Windows 桌面版在做什麼:從聊天助手到「可被指派工作的代理」 傳統的 AI 助手多半停在「你問我答」,頂多生成一段程式碼。Codex 桌面版更貼近開發現場: 能理解專案脈絡:在你允許的範圍內讀取檔案結構、關鍵檔案與規格,才能做跨檔案修改。 能被指派任務:把工作拆成規格、實作、測試、文件、除錯等可交付項目,逐步回報。 能多代理並行:同一時間安排不同代理處理不同子任務,再由你或主代理整合成果。 這意味著它更像「AI 開發工作台」:你不只是拿到一段答案,而是拿到一個可追蹤、可驗收、可回滾的修改過程。...

Anthropic 推出「AI 取代偵測器」(可理解為一種工作被自動化取代程度的評估工具),把許多企業一直想做、卻很難做得一致的事變得更具體:不是泛泛談「AI 會不會取代我」,而是把日常工作拆成流程與任務,評估哪些環節最容易被 AI 介入、哪些仍高度依賴人類判斷,並提供可用於決策的訊號。 這類工具之所以引起關注,原因很現實:AI 進入組織的速度,往往比「職務重新設計、教育訓練、治理與風險控管」更快。若缺乏一個共同語言,內部討論很容易變成兩極——一方恐慌、一方迷信效率。 這個「偵測器」到底在偵測什麼? 把「被取代」講清楚,通常要分成三層: 任務層(Task):例如撰寫會議摘要、整理報價表、回覆制式客服、初步合約比對。 流程層(Workflow):把任務串起來的端到端流程,例如「接單→對帳→出貨→客服追蹤」。 職務層(Role):一個人承擔的多種流程與責任,往往包含跨部門協調、例外處理、對外溝通等。 「AI 取代偵測器」的價值通常不在於替你下結論說「這個職位會消失」,而是協助你看到: 哪些工作更像「可標準化、可驗證、輸入輸出明確」——較容易自動化 哪些工作常碰到例外、需要情境判斷與責任歸屬——較難完全交給模型 哪些工作其實會變成「人機協作」:AI 做初稿、人做把關與決策 為什麼它會對企業「特別有用」 多數企業導入 AI 的第一步不是缺工具,而是缺範圍界定與優先順序。同樣是導入生成式 AI:...

在生成式 AI 快速滲透辦公軟體的今天,ChatGPT Excel 外掛與進階財務數據整合,正在重塑金融專業人士的日常工作。對於長期仰賴 Excel 進行財務建模與投資分析的產業來說,這不僅是工具升級,而是一場工作流程與風險管理邏輯的結構性變革。 為何「ChatGPT for Excel」是財務團隊的轉折點 金融與企業財務部門幾乎離不開 Excel: 從三表模型、估值模型、預算編列到風險壓力測試,試算表是整個決策流程的「運算引擎」。但過去幾年,Excel 也暴露出幾個痛點: 建模門檻高,新人需要數月甚至數年才能熟練 場景分析與版本控制繁瑣,極易出錯 財務數據來源分散,在不同系統與平台間來回複製貼上 高階人員浪費大量時間在重複性、機械化操作 ChatGPT for Excel 外掛的出現,等於把一個懂財務、懂 Excel 的...

Google I/O 2026:AI 世代的年度關鍵大會 Google I/O 2026 開發者大會確定在 5 月 19 日至 20 日於加州山景城登場,主題毫無懸念地再次鎖定「AI 為中心」。從會前釋出的資訊可以看出,今年的焦點將圍繞在 Gemini 3、大模型工具鏈與 Android 生態系的全面升級,這不只是一次產品發表會,更是 Google 嘗試重塑開發者心態與使用者期待的一次總動員。 對開發者、產品經理與創業團隊來說,Google I/O 2026...

GPT-5.4 正式登場,標誌著生成式 AI 從聊天玩具走向專業生產力工具的新階段。對於追求效率與精準的企業與專業人士而言,GPT-5.4 不只是「更強一點」的模型,而是一套圍繞長文本處理、推理能力與成本結構全面升級的 AI 基礎設施。 GPT-5.4 的核心賣點:長脈絡與高效率的結合 GPT-5.4 最顯著的變化之一,是提供最高達百萬 token 等級的上下文長度。這代表什麼意義? 一次讀完整本技術手冊或市場研究報告並進行分析 將多輪會議記錄、往來郵件與附件整合成一份決策簡報 在不中斷對話的情況下,長期追蹤同一專案的來龍去脈 更重要的是,GPT-5.4 在 token 使用效率上也有顯著提升,可以用更少的 token 完成與前一代相同難度的任務。對企業來說,這直接轉化為推理成本下降與延遲縮短,使長上下文應用不再是只存在於簡報中的概念,而是可以大規模落地的現實選項。 GPT-5.4 Pro:為高流量與即時場景而生...

大型語言模型蒸餾正成為當前 AI 戰略版圖上的關鍵詞,特別是在中美大模型競爭與技術擴散的脈絡下。當我們討論中國大型語言模型能否「追上甚至超越」美國前沿模型時,蒸餾究竟是決定性武器,還是被誇大的助攻工具,是一個值得冷靜拆解的問題。 本文聚焦於一個核心提問:蒸餾對大型語言模型的真正影響有多大? 什麼是大型語言模型蒸餾?從「知識轉移」到「合成資料」 在工程實務中,「蒸餾」已遠遠超出教科書中狹義的知識蒸餾定義。如今談的大型語言模型蒸餾,大致包含以下幾層意義: 使用更強模型的輸出,去訓練較小或較弱的模型 大量生成高品質合成資料(synthetic data),再用來微調或後訓練 在特定能力上進行「能力搬運」,例如推理、Agent 行為、工具調用等 換句話說,蒸餾已經不只是「壓縮一個模型」,而更像是用算力把一部分模型能力轉成資料資產,再讓自己的模型去學。 在當前 LLM 開發流程中,蒸餾與合成資料的重要性體現在: 補足人類標註資料的成本與稀缺 快速試驗新能力(如長鏈推理、複雜工具編排) 讓中型模型在特定場景逼近或超越巨型模型表現 也因此,當談到中國大型語言模型的突飛猛進時,外界自然會把目光聚焦到:這些模型到底從美國前沿 API 蒸餾了多少能力? 蒸餾操作的真實規模:數十億還是數千億 Tokens? 近期有國際公司公開指出,多家中國實驗室透過...

中國利用ChatGPT企圖發動對日本首相的影響操作,正把亞洲的資訊戰推向新階段。當中國執法機關被指試圖透過生成式AI策動跨國輿論戰時,日本與整個民主世界都被迫重新思考「政治安全」與「數位安全」之間的界線究竟在哪裡。 中國利用ChatGPT鎖定日本首相的案例:訊號大於成效 在最新曝光的一起事件中,一名與中國執法單位相關的使用者,被指多次利用大型語言模型,要求協助設計一場針對日本首相高市早苗的線上影響操作。內容包含: 批量生成負面留言與輿論帶風向文案 捏造關於移民政策與生活成本的民怨投訴 將高市描繪成極右派、軍國主義與歷史修正主義者 利用關稅與對美國不滿情緒,將憤怒導向日本政府 同時加入歌頌內蒙古人權與經濟狀況的宣傳內容 由於模型本身的安全防護拒絕了這類明顯帶有操弄目的的請求,相關帳號最後遭到封鎖。但後續發現,同一名使用者之後仍回到系統,請求協助潤飾「行動成果報告」,內容顯示該場影響操作已改用其他本地AI工具繼續推進。這透露出一個關鍵事實:就算某一款國際主流AI系統設有限制,真正有意進行資訊戰的行為者,仍可輕易改用不設防或本地部署的模型來達成目的。 更值得注意的是,這名使用者在報告中提到,相關「特別行動」橫跨數百個海外與中國國內平台,以數千個帳號散布數萬篇內容,甚至對在外異議人士、人權團體與批評者展開長期騷擾與抹黑。從資訊戰角度看,這已不再是零星的「網路帶風向」,而是工業化的「數位鎮壓作戰」。 從網路水軍到生成式AI:影響操作的全面升級 中國的線上影響操作並非今日才出現。過去多年,外界已多次揭露,大量「網路水軍」與虛假帳號長期在各國社群平台上推送親中敘事、攻擊批評者,並干預他國政治議題。不同的是,生成式AI的出現,讓這種操作從「人海戰術」升級為「演算法放大」。 在這起針對日本首相的案件中,可以清楚看到幾項關鍵升級趨勢: 內容產能倍增:AI可以在短時間內生成大量不同語氣、不同語言版本的貼文,大幅降低「洗版」成本。 語言與在地化門檻下降:透過自動翻譯與在地化調整,外國操作者可以「講出像當地人會說的話」,降低被識破的難度。 精準投放與心理操作:在掌握關鍵詞、熱門議題後,AI能快速產出貼近特定族群焦慮的敘事,例如「年輕世代被社福負擔壓垮」這類情緒化說法。 內部作業也AI化:不只對外發文,連內部行動報告、成效追蹤與策略調整也由AI協助撰寫,讓整個資訊戰行動更像一條完整的「數位產線」。 這些能力疊加起來,即使單一行動的外部成效有限(例如數萬篇貼文中真正有高互動者極少),也象徵一種長期、結構化的施壓機制:讓所有批評者都知道,自己隨時可能成為下一波「輿論攻擊」的目標。 為何鎖定日本首相高市早苗? 高市早苗成為中國影響操作鎖定的對象,絕非偶然。近年來,她在國安與對中政策上的立場鮮明,包括: 對台灣安全採取較為明確的支持姿態 將可能的台海危機視為日本的「生存威脅」 對中國內部人權議題,例如內蒙古民族政策,提出公開批評 這些立場直接撞上北京的「紅線」,在戰略思維上就會被視為必須被削弱公信力的對象。於是,我們在這次曝光的行動計畫中看到幾個典型手法:...

近期 AI 圖像生成技術發展非常迅速,而 Nano Banana 2 可以說是近期 AI 圖像生成領域最受關注的新模型之一。相比上一代版本,Nano Banana 2 在 生成速度、圖像解析度以及生成成本 等方面都有顯著提升。 不少 AI 社群甚至認為,Nano Banana 2 有機會成為下一代主流 AI 圖像生成模型 (AI Image...

伊朗戰爭下,AWS 數據中心無人機攻擊成為全球雲端產業最震撼的警訊之一。當無人機在阿聯酋上空擊中雲端機房,我們才真正意識到:所謂「在雲端」的服務,其實非常具體、非常脆弱,而且正在成為戰爭的一部分。 無人機攻擊打破「雲端無所不在」的迷思 這次伊朗戰爭延伸出的無人機攻擊,鎖定阿聯酋與波灣地區的 AWS 數據中心,讓外界第一次清楚看到幾個殘酷現實: 雲端服務仍然依賴特定城市、特定園區的實體機房 即使是全球最大的雲端供應商,也無法保證在戰火前「零停機」 地緣政治風險,不再只是能源與航運問題,而是直接衝擊雲端與金融基礎設施 阿聯酋原本被視為區域金融、物流與 AI 計算樞紐,如今則成為無人機攻擊的前線。AWS 數據中心無人機攻擊,不只是一次營運事故,而是宣告:雲端基礎建設正式納入戰略軍事目標清單。 AWS 數據中心無人機攻擊對企業與用戶的連鎖效應 當 AWS 在阿聯酋與鄰近國家的數據中心受損,最直接的影響並不是全球性大當機,而是「區域性、選擇性、卻極具破壞力」的服務中斷: 地區性銀行與金融科技服務一度無法交易或登入 本地電商、叫車、外送與支付應用程式大量出錯、延遲甚至完全離線 使用該區域作為主生產環境的跨國企業,被迫緊急切換到其他地區 從技術角度來看,AWS 架構原本就允許跨可用區容錯,但這種設計假設「同一區域不會同時有多座機房毀損」。當無人機攻擊直接擊中或波及多個設施,整個區域的冗餘設計瞬間被拉到極限,甚至直接突破。 這次事件對雲端產業最大的衝擊,不只是短期服務中斷,而是長期信任與風險模型的重估。...

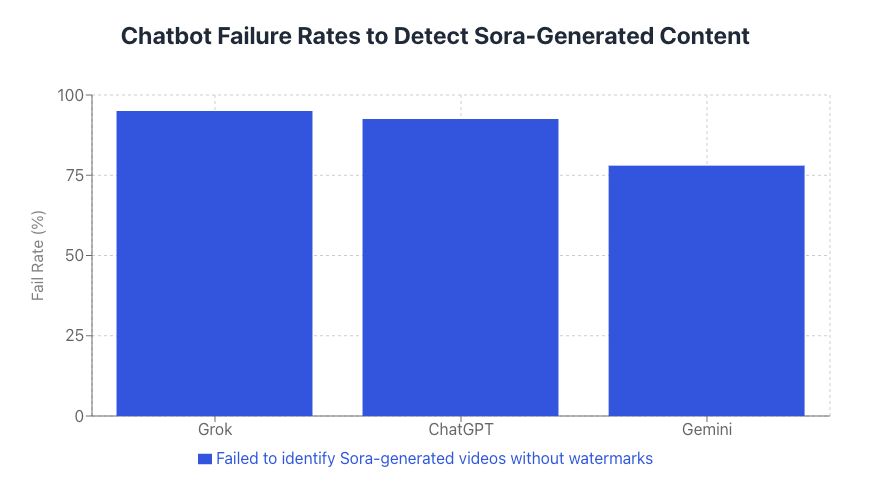

AI 聊天機器人辨識 AI 生成影片的能力,正在成為資訊安全與選舉公信力的關鍵議題。當深偽技術與文字轉影片模型愈來愈強大時,如果連 AI 聊天機器人本身都難以分辨 AI 生成影片與真實畫面,我們對「數位真相」的基本假設就必須全面重寫。 AI 聊天機器人為何難以辨識 AI 生成影片? 多數人直覺會以為:既然聊天機器人是 AI,理論上應該更懂得如何識破 AI 生成影片。事實剛好相反,現階段的主流程設計,主要是為了「理解與生成內容」,而不是為了「鑑定真偽」。 技術架構上的天生盲點 當前主流 AI 聊天機器人(包括 ChatGPT、Gemini、Grok 等)多半是: 以文字大型語言模型為核心 再疊加影像、影片理解能力,變成多模態模型...

生成式 AI 正在重塑數位廣告版圖,而「ChatGPT 廣告」無疑是這場變革的核心關鍵。當全球用戶把各種生活與工作決策搬進對話式 AI,中長期來看,這不只是一項新功能,而是一個足以改寫 Google、Meta 等巨頭遊戲規則的廣告新戰場。 生成式 AI 與 ChatGPT 廣告:為何是廣告業的下一個爆點? 與傳統搜尋廣告或社群廣告不同,生成式 AI 的互動是「連續對話」而非「單次點擊」: 使用者會在 ChatGPT 裡規劃旅遊、比較產品、設計行銷策略、研究投資工具 這些對話高度具備「商業意圖」,遠比滑過一則動態牆貼文更接近最終決策 AI 能即時理解上下文,精準判斷使用者處在決策旅程的哪一個階段 當一個擁有數以億計活躍用戶的對話式 AI,開始提供 ChatGPT...

![[AI學堂] Nano Banana 2 實測|最強 AI 圖像生成模型?速度暴升+4K 圖片生成+成本大降解析](https://drjackeiwong.com/wp-content/uploads/2026/03/20260304-YT.jpg)