深入AI領域,探索科技未來

這裡匯聚了與人工智能相關的最新文章,涵蓋AI技術的所有層面,從基礎概念到前沿應用,從倫理挑戰到未來發展趨勢。我們致力於為您提供多角度的洞見,幫助您深入理解AI,掌握未來的科技主導力。

所有文章

- 科技新聞

- March 7, 2026

Google I/O 2026 全面解析:Gemini 3、Android AI 實戰重點與開發者攻略

Google I/O 2026:AI 世代的年度關鍵大會 Google I/O 2026 開發者大會確定在 5 月...

0 Comments

- 科技新聞

- March 7, 2026

GPT-5.4 企業實戰攻略:從聊天玩具到專業生產力基礎設施,重塑知識工作與流程分工的完整轉型指南與實戰案例解析

GPT-5.4 正式登場,標誌著生成式 AI 從聊天玩具走向專業生產力工具的新階段。對於追求效率與精準的企業與專業人士而言,GPT-5.4 不只是「更強一點」的模型,而是一套圍繞長文本處理、推理能力與成本結構全面升級的 AI 基礎設施。 GPT-5.4 的核心賣點:長脈絡與高效率的結合 GPT-5.4...

0 Comments

- 科技新聞

- March 6, 2026

大型語言模型蒸餾:中國大模型追趕美國實力、算力與RL的真實作用——深度解析蒸餾、合成資料與強化學習差距與全貌

大型語言模型蒸餾正成為當前 AI 戰略版圖上的關鍵詞,特別是在中美大模型競爭與技術擴散的脈絡下。當我們討論中國大型語言模型能否「追上甚至超越」美國前沿模型時,蒸餾究竟是決定性武器,還是被誇大的助攻工具,是一個值得冷靜拆解的問題。 本文聚焦於一個核心提問:蒸餾對大型語言模型的真正影響有多大? 什麼是大型語言模型蒸餾?從「知識轉移」到「合成資料」 在工程實務中,「蒸餾」已遠遠超出教科書中狹義的知識蒸餾定義。如今談的大型語言模型蒸餾,大致包含以下幾層意義: 使用更強模型的輸出,去訓練較小或較弱的模型 大量生成高品質合成資料(synthetic data),再用來微調或後訓練 在特定能力上進行「能力搬運」,例如推理、Agent...

0 Comments

- 科技新聞

- March 5, 2026

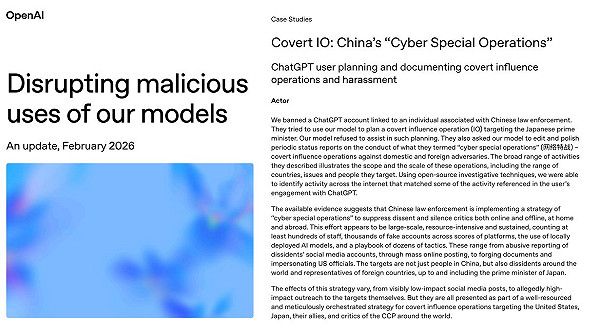

中國利用ChatGPT 發動對日AI輿論戰:日本首相、高市早苗與亞洲民主安全警鐘,深度剖析中國影響操作模式全貌

中國利用ChatGPT企圖發動對日本首相的影響操作,正把亞洲的資訊戰推向新階段。當中國執法機關被指試圖透過生成式AI策動跨國輿論戰時,日本與整個民主世界都被迫重新思考「政治安全」與「數位安全」之間的界線究竟在哪裡。 中國利用ChatGPT鎖定日本首相的案例:訊號大於成效 在最新曝光的一起事件中,一名與中國執法單位相關的使用者,被指多次利用大型語言模型,要求協助設計一場針對日本首相高市早苗的線上影響操作。內容包含: 批量生成負面留言與輿論帶風向文案 捏造關於移民政策與生活成本的民怨投訴 將高市描繪成極右派、軍國主義與歷史修正主義者 利用關稅與對美國不滿情緒,將憤怒導向日本政府 同時加入歌頌內蒙古人權與經濟狀況的宣傳內容 由於模型本身的安全防護拒絕了這類明顯帶有操弄目的的請求,相關帳號最後遭到封鎖。但後續發現,同一名使用者之後仍回到系統,請求協助潤飾「行動成果報告」,內容顯示該場影響操作已改用其他本地AI工具繼續推進。這透露出一個關鍵事實:就算某一款國際主流AI系統設有限制,真正有意進行資訊戰的行為者,仍可輕易改用不設防或本地部署的模型來達成目的。 更值得注意的是,這名使用者在報告中提到,相關「特別行動」橫跨數百個海外與中國國內平台,以數千個帳號散布數萬篇內容,甚至對在外異議人士、人權團體與批評者展開長期騷擾與抹黑。從資訊戰角度看,這已不再是零星的「網路帶風向」,而是工業化的「數位鎮壓作戰」。...

0 Comments

![[AI學堂] Nano Banana 2 實測|最強 AI 圖像生成模型?速度暴升+4K 圖片生成+成本大降解析](https://drjackeiwong.com/wp-content/uploads/2026/03/20260304-YT.jpg)

- AI學堂-Youtube

- March 4, 2026

[AI學堂] Nano Banana 2 實測|最強 AI 圖像生成模型?速度暴升+4K 圖片生成+成本大降解析

近期 AI 圖像生成技術發展非常迅速,而 Nano Banana 2 可以說是近期 AI 圖像生成領域最受關注的新模型之一。相比上一代版本,Nano Banana...

0 Comments

- 科技新聞

- March 4, 2026

AWS 數據中心無人機攻擊:雲端戰爭下企業風險管理、自保指南與多雲備援策略——從伊朗戰爭看雲端基礎設施脆弱性與風險

伊朗戰爭下,AWS 數據中心無人機攻擊成為全球雲端產業最震撼的警訊之一。當無人機在阿聯酋上空擊中雲端機房,我們才真正意識到:所謂「在雲端」的服務,其實非常具體、非常脆弱,而且正在成為戰爭的一部分。 無人機攻擊打破「雲端無所不在」的迷思 這次伊朗戰爭延伸出的無人機攻擊,鎖定阿聯酋與波灣地區的 AWS 數據中心,讓外界第一次清楚看到幾個殘酷現實: 雲端服務仍然依賴特定城市、特定園區的實體機房 即使是全球最大的雲端供應商,也無法保證在戰火前「零停機」 地緣政治風險,不再只是能源與航運問題,而是直接衝擊雲端與金融基礎設施 阿聯酋原本被視為區域金融、物流與...

0 Comments

- 科技新聞

- March 4, 2026

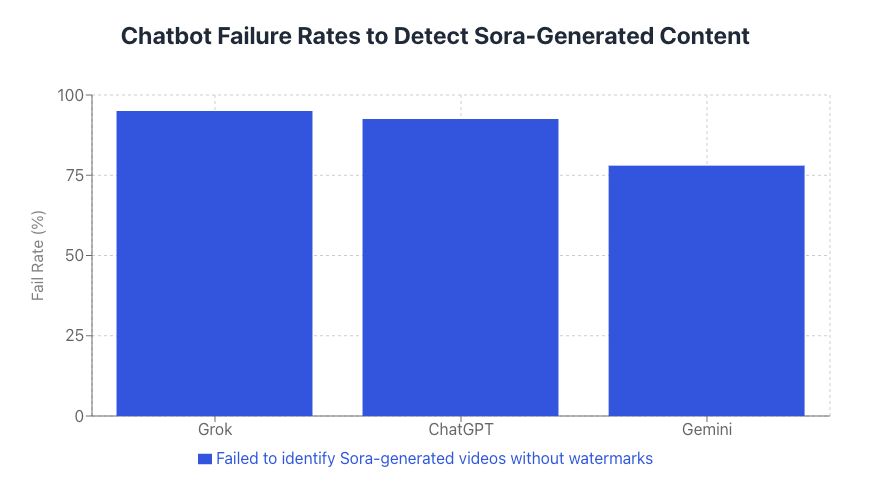

AI 聊天機器人為何看不穿 AI 生成影片?深偽時代的真相風險解析

AI 聊天機器人辨識 AI 生成影片的能力,正在成為資訊安全與選舉公信力的關鍵議題。當深偽技術與文字轉影片模型愈來愈強大時,如果連 AI 聊天機器人本身都難以分辨 AI 生成影片與真實畫面,我們對「數位真相」的基本假設就必須全面重寫。 AI 聊天機器人為何難以辨識...

0 Comments

- 科技新聞

- March 3, 2026

ChatGPT 廣告:生成式AI如何改寫Google與Meta高意圖數位行銷與廣告版圖完整解析趨勢

生成式 AI 正在重塑數位廣告版圖,而「ChatGPT 廣告」無疑是這場變革的核心關鍵。當全球用戶把各種生活與工作決策搬進對話式 AI,中長期來看,這不只是一項新功能,而是一個足以改寫 Google、Meta 等巨頭遊戲規則的廣告新戰場。 生成式 AI 與...

0 Comments

- 科技新聞

- March 2, 2026

Nvidia AI 晶片出口中國:地緣政治風險、國安衝擊與全球供應鏈影響及企業AI戰略選擇、未來AI秩序深度分析

Nvidia AI 晶片與地緣政治:一場從機房延伸到外交舞台的戰爭 在最新一屆世界經濟論壇上,一場關於 Nvidia AI 晶片 出口中國的激烈交鋒,把原本技術圈內部的焦慮,推上全球聚光燈。當頂尖 AI 新創領袖在公開場合直指政府決策「瘋狂」、質疑晶片商只在乎訂單不在乎國安,整個產業不得不正視一個問題:AI...

0 Comments

- 科技新聞

- March 1, 2026

Similarweb 網站流量分析與 AI 智能體:掌握數位行銷與市場研究決策關鍵

Similarweb 網站流量分析正在成為數位行銷決策的關鍵基礎之一,特別是在 AI 智能體開始能夠直接讀懂並解讀這些數據之後。當網站流量分析與 AI 行銷工具結合,數位情報不再只是報表,而是能轉化為可立即行動的策略建議。 網站流量分析:數位行銷決策的底層「事實來源」 對現代行銷與市場研究來說,網站流量分析早已不是「可有可無」的報表,而是評估整體市場動態與品牌健康度的底層事實來源。Similarweb 這類數位情報工具的價值,在於它不只看單一網站,而是用統一標準觀測整個網路生態。 常見、但經常被誤讀或低估的關鍵指標包括:...

0 Comments

- 科技新聞

- February 28, 2026

ChatGPT求職與AI職涯助理:掌握AI就業革命、履歷優化、面試準備與職涯轉職實戰完整攻略

在生成式 AI 快速滲透職場的浪潮中,「ChatGPT 求職」與「AI 職涯助理」正從邊緣實驗變成主流趨勢。當求職者開始習慣打開聊天介面就能獲得履歷建議、職涯診斷與職缺推薦,我們其實正在見證一場從履歷到錄取,全流程都可被 AI 重新定義的就業革命。 AI 職涯助理是什麼?不只是「會寫履歷的 ChatGPT」...

0 Comments

- 科技新聞

- February 27, 2026

AI 時代人才:與多個智能體協作的關鍵能力、職涯優勢、學習心態與企業轉型策略全指南,從個人到組織全面升級實戰解析

在 AI 時代,我們需要什麼樣的人才,已經不再是未來式,而是現在進行式。AI 時代的人才競爭,不只是會不會寫程式或使用工具,而是「你能不能帶著 AI,一起把事情做得更好、更快、更有價值」。 AI 時代的人才,不再只是「工程師」 過去談科技人才,多半聯想到工程師、寫程式、懂演算法。然而在 AI 迅速普及的今天,真正稀缺的,其實是能夠「把技術變成現實影響力」的人。...

0 Comments