AI人才搶人戰已經不是誇飾用語,而是當前科技產業最真實的寫照。從天價股權激勵到數億美元等級的薪酬方案,這場 AI 人才搶人戰正悄悄改寫全球就業與薪資版圖。 AI人才搶人戰背後:資本、技術與壟斷野心 要理解為何企業願意在 AI 人才上砸下天文數字,必須先看這三個關鍵: 資本對成長故事的渴望 技術路線的寡頭化趨勢 對未來壟斷地位的想像 第一,生成式 AI 與大模型已被資本市場視為下一個「基礎設施級」技術,誰能率先建立壟斷級平台,未來就可能在雲端、廣告、企業服務等多個賽道收割長期超額利益。 第二,大模型屬於「贏家通吃」特性明顯的領域:資料、算力與頂尖研究人才高度集中,落後者很難透過砸錢短時間追上,因此所有巨頭都在搶同一批人。 第三,真正能拉開差距的,不再是一般軟體工程師,而是少數懂模型原理、能推進前沿研究、又能落地產品的複合型 AI 人才,市場自然願意用極端溢價換取他們的時間與創造力。 500億美元級股權激勵:用股票買未來 近幾年,有領先的 AI 企業直接設立約 500 億美元規模的股票激勵池,金額大約相當於公司估值的一成,專門用來在五年內綁住 AI...

OpenAI 收購 Convogo 團隊:AI 雲端與主管教練工具的關鍵一役 OpenAI 收購高階主管教練 AI 工具 Convogo 背後的團隊,再次把「acqui-hire 人才併購」與「AI 雲端平台」推上焦點。這不只是另一宗 AI 產業併購,而是大模型公司如何搶占企業級應用入口的縮影,尤其是在領導力發展、HR 科技與顧問服務這三大場景。 Convogo 的產品聚焦高階主管教練與顧問市場,協助自動化領導力評估、回饋報告與相關文字工作。如今產品將被陸續關閉,而核心團隊則轉向為 OpenAI 打造 AI 雲端能力,這個轉折本身就說明了產業優先順序正在改寫。 為何 OpenAI...

美國一名聯邦法官近日裁定,馬斯克控告OpenAI的訴訟可以進入正式審判程序,而不是在程序階段即遭駁回。 這起「馬斯克控告OpenAI」的案件,表面上是創辦人決裂與股權爭奪,實際上卻是一場關於 AI 未來治理模式的公眾公投:究竟「非營利使命」能否在龐大的資本與權力壓力下存活? 在生成式 AI 爆炸成長、各國監管仍追趕不及的此刻,這宗訴訟為產業敲響了一記警鐘:AI 創新若完全交給董事會與投資人決定,社會能否接受其外部成本與風險? 馬斯克控告OpenAI:不只是私人恩怨 這場訴訟的核心,是對「非營利轉營利」的強烈質疑。指控的主軸可以概括為三點: 當初以「非營利、造福人類」為號召,吸引捐助與人才加入 隨著技術突破與商業機會浮現,組織結構逐步轉向營利導向 重大商業合作與資本挹注,讓外部投資人與合作夥伴取得實質影響力 從外界角度來看,這起OpenAI訴訟不只關乎合約條款是否被違反,更關乎一個根本問題: 當 AI 實驗室從「為公益」轉向「為獲利」時,原本對社會做出的承諾,還算數嗎? 非營利轉營利,引爆的三大結構性爭議 1. 公共利益 vs 股東利益:誰說了算? AI 的特殊之處在於,它同時是:...

企業 AI 代理管理平台正在成為新一代企業數位轉型的核心關鍵。對想要系統性導入生成式 AI 的組織而言,光有大型語言模型不再足夠,真正的戰場已經移轉到「如何建構與管理 AI 代理」這一層基礎設施。 企業為何需要 AI 代理管理平台? 過去兩年,多數企業導入生成式 AI 的方式,大多停留在聊天機器人、問答助理或單一流程自動化工具。這些應用固然有價值,但難以在全公司規模上真正改變工作方式。AI 代理管理平台的出現,正是為了解決這個瓶頸。 一個成熟的企業級 AI 代理管理平台,至少要做到: 讓企業能批量建立、部署與維運多個 AI 代理 統一控管這些代理能存取的資料與系統 監控、追蹤、調整代理行為與績效 與既有 IT、雲端與安全架構順暢整合...

隨著 Perplexity 官方近期 更新合作夥伴促銷和推薦計劃(Partner Promotions and Referral Programs)條款,所有透過合作活動(例如香港電訊旗下 CSL / 1O1O / Club Sim 或 HKT 等)免費獲得的一年 Perplexity Pro 進階 AI 服務 訂閱,在啟用後必須 提供有效的信用卡或借記卡資料...

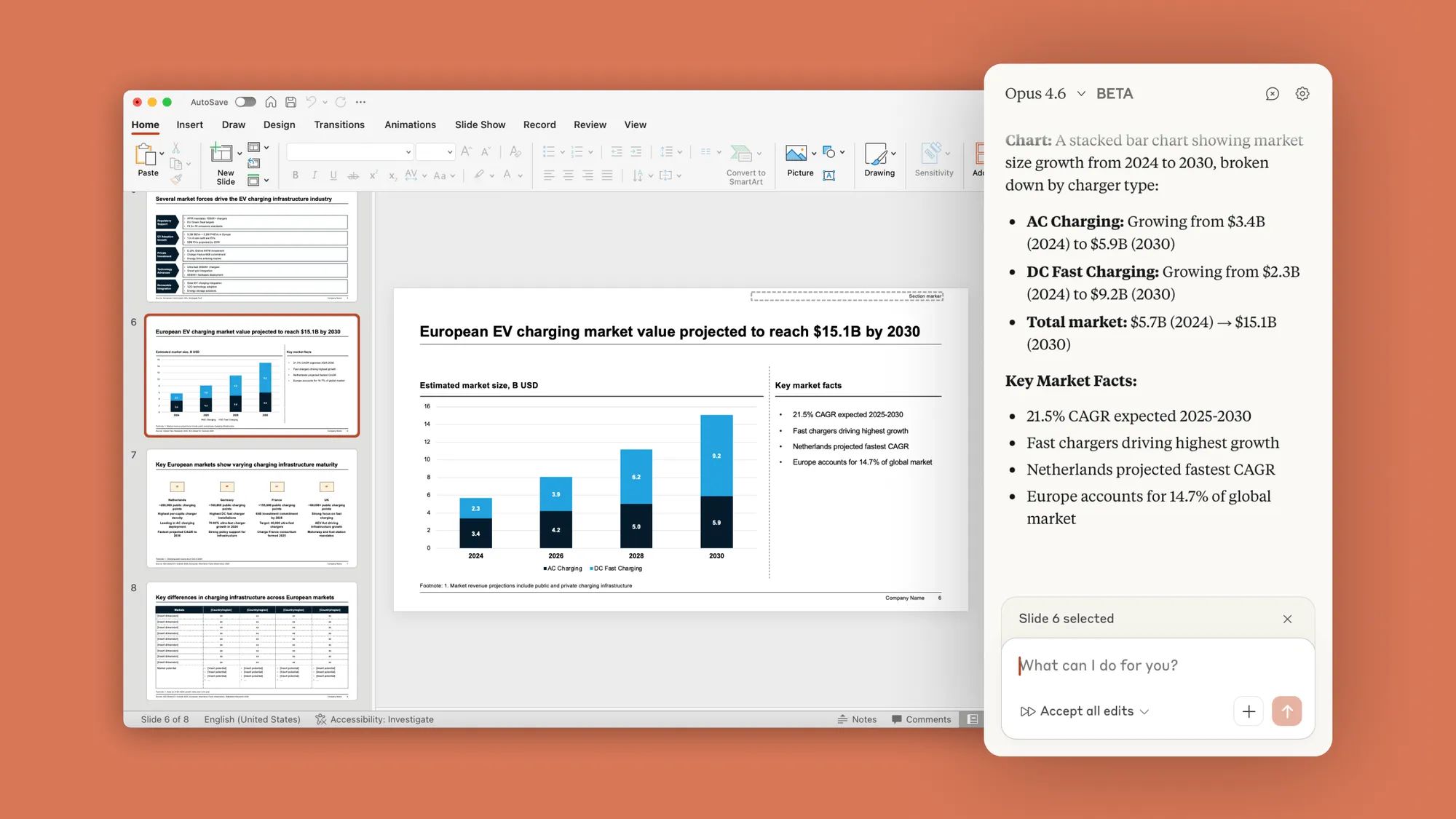

在日常工作裡,如果你大量製作簡報,「Claude in PowerPoint」可以徹底改變你規劃與編輯投影片的方式。這個 AI 簡報外掛不是單純幫你寫幾行文字,而是深度融入 PowerPoint 工作流程,協助你從結構、內容到視覺呈現一次到位。 什麼是 Claude in PowerPoint?為什麼值得使用? Claude in PowerPoint 是一款直接嵌入 PowerPoint 的 AI 助手,可以讀取你目前開啟的簡報檔、版面配置與公司範本,依照既有的版型自動產生或修改投影片。對需要反覆調整簡報的顧問、內部專案負責人、行銷與高階主管來說,這是一個真正能省下數小時繁瑣工作的工具。 使用 Claude in PowerPoint,你可以: 依照公司或客戶範本,自動生成全新投影片...

Google Gemini Pro 模型再次在 AI 基準測試中拿下破紀錄分數,成為產業焦點。對正在評估大型語言模型與 AI 代理方案的企業與開發者而言,這不只是分數競賽,而是下一輪生成式 AI 版圖重排的前哨戰。 Google Gemini Pro 模型 3.1:不只是「小幅升級」 最新版本的 Gemini 3.1 Pro 被定位為通用型大型語言模型,但從公開資訊與實際回饋來看,它的升級已經超出「例行更新」的範疇。 幾個關鍵變化值得特別留意: 在多步推理與長鏈思考任務上的表現明顯提升 在專業領域任務(如程式設計、商業分析、法務摘要)中的穩定度更高 與代理框架結合時,對任務分解與規劃的能力更成熟...

你可能成日用 ChatGPT / Gemini,但有時會覺得: 其實大多數問題,唔係模型「唔得」,而係你未用對提示方式(Prompt)。 呢篇文章我會用最易明方式,帶你跟住白皮書由淺入深走一遍:由最基本 Prompt、到「加例子」、到「指定角色」、到「一步步推理」、再到「AI 幫你自動生成 Prompt」,最後仲有 Code Prompting(寫程式 / 解釋程式 / 翻譯程式 / Debug)。 0|先講清楚:Prompt Engineering 其實係咩? 你可以當 AI 係一個「超強文字助手」。但佢唔會讀心,所以: Prompt...

Sonnet 4.6:中型大模型躍升為主流 AI 助手的關鍵一役 Sonnet 4.6 的推出,不只是單純的模型升級,而是整個 Claude 生態系策略的又一次調整。對多數開發者與一般使用者而言,未來日常接觸到的 AI 助手,很大機率就是這個中型的 Sonnet 4.6,而不是最頂級的旗艦模型。 這樣的選擇背後,反映了生成式 AI 正走向「實用優先」的階段:速度、成本、可靠性與可控性,開始比「排行榜上誰最高分」更重要。 Sonnet 4.6 的定位:在效能與成本之間找到甜蜜點 Sonnet 系列一直被定位在「中型模型」,介於輕量的 Haiku 與頂級的 Opus...

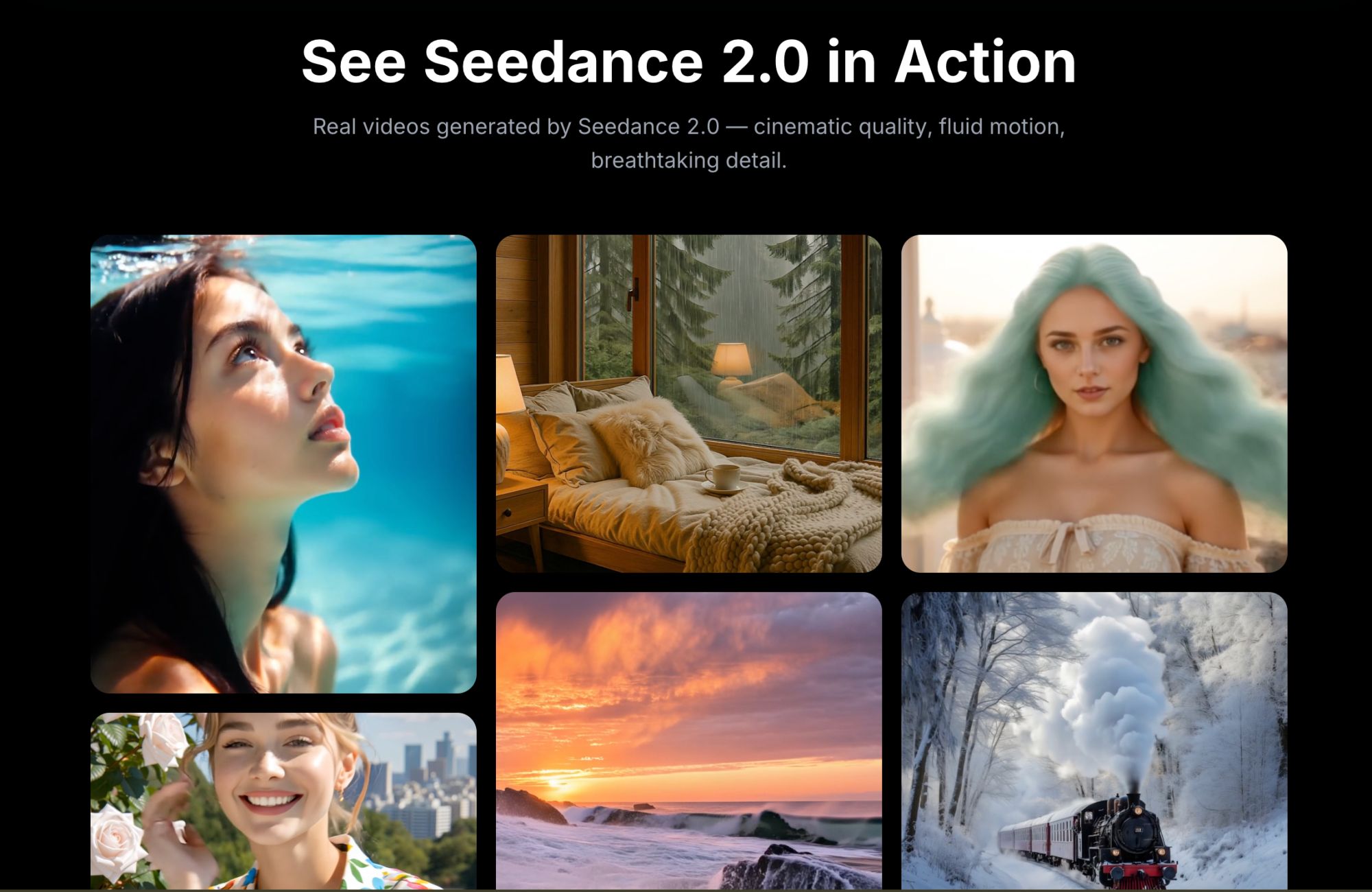

在生成式 AI 加速進化的此刻,「Seedance 2 AI 影片生成器」正成為全球創作者最關注的關鍵字之一。這款多模態 AI 影片工具,不只是讓你用文字就能生成影片,更是把「電影級畫面+聲音+鏡頭運動」打包成一個雲端服務,徹底改寫影像內容的生產方式。 Seedance 2 是什麼?多模態 AI 影片生成器的下一站 Seedance 2 是一款專為「AI 影片生成」打造的多模態模型,支援四種輸入:文字提示、圖片、影片與音訊。使用者可以在一次生成中同時上傳多張圖片、數段影片與音訊,配合文字描述,讓 AI 自動組合成 4–15 秒不等的短片,畫面與聲音同步生成。 這樣的多模態設計,意味著 Seedance 2...

個人 AI 助理 OpenClaw 正在改寫軟體產業的遊戲規則 個人 AI 助理 OpenClaw 的崛起,正在把「本地優先」AI 代理推向舞台中央。當一個開源的個人 AI 智能體,能直接在你的電腦上操作滑鼠鍵盤、讀取檔案、控制各種裝置時,整個應用程式生態勢必被重新洗牌,有人甚至預期未來 80% 的應用程式將會自然消失。 這並不是危言聳聽,而是對技術路線與使用者需求的冷靜判斷。 為什麼「本地優先」個人 AI 助理這麼重要? 傳統的 AI 服務大多部署在雲端,只接受輸入、輸出文字或圖片,真正能控制的東西有限。本地優先的個人 AI 助理像...

在AI時代,教育現場正經歷前所未有的震盪。生成式AI與ChatGPT等工具,不只改變學生寫作業的方式,也正在重塑老師教學、評量與學術誠信的基本規則。 AI時代下的教育:當「完美作業」變成警訊 過去,數位學習代表的是線上選課、下載教材、利用搜尋引擎蒐集資料,學生仍需花時間閱讀、整理與消化資訊,老師也能從作業風格與錯誤模式判斷學習狀況。 如今,生成式AI出現後,很多老師開始發現: 作業答案出奇一致、幾乎沒有錯字或計算錯誤 英文作文用字華麗,卻與學生平時口語或課堂表現明顯脫節 報告架構完整,但缺少個人觀點與原創思考 這些「近乎完美」的作業,不再是值得高興的成就,而是師生互信被動搖的警訊。老師不知道該相信誰的努力,學生也擔心被誤判作弊,雙方都在不安中前進。 學生用ChatGPT寫作業:偷懶,還是新型學習? 討論AI教育時,一個最常見的問題是:「學生用了ChatGPT,是不是代表不用讀書了?」 事實上,學生使用AI的動機與方式非常多元: 為了「趕作業」:把題目貼進去,直接複製答案 為了「查觀念」:請AI用簡單文字解釋艱深概念 為了「整理資訊」:讓AI彙整長篇資料、幫忙抓重點 為了「潤飾語言」:請AI改寫句子、修正文法 問題不在於學生是否使用AI,而在於: 他們是否仍有「自己思考」? 他們是否能分辨AI回答的錯誤與偏誤? 他們是否清楚在何種情境下,使用AI已經違反學術誠信? 近年有調查顯示,使用AI聊天機器人完成作業的青少年比例在短時間內幾乎翻倍成長,這代表「AI輔助學習」已成新常態。若教育仍假裝這件事不存在,只會讓誠實面對工具的學生處於不利位置,讓偷偷使用的人繼續鑽漏洞。 老師用AI備課:被取代,還是升級? 在另一端,許多老師也開始用生成式AI備課、出題、整理教材: 請AI根據課綱產生練習題與解答 要AI幫忙設計生活化的數學情境題...