近年來,人工智能技術的快速發展,不僅推動了AI聊天機器人如ChatGPT的普及,也引發了關於其安全性和倫理性的廣泛討論。ChatGPT這款由OpenAI開發的AI聊天機器人,已經展現出驚人的能力,包括生成創意內容、回答複雜問題,甚至成功地破解了一些網站使用的驗證機制,如CAPTCHA。 CAPTCHA是一種廣泛使用的圖形驗證碼,設計目的是區分人類和自動化程式,以防止機器人執行不當行為。然而,最新的研究發現,ChatGPT的代理能力已經達到可以自行點擊並通過「我不是機器人」的reCAPTCHA驗證,對於資安界來說,這是一個令人關注的發展。 ChatGPT如何破解CAPTCHA ChatGPT的破解CAPTCHA能力主要依靠其強大的視覺識別和操作能力。根據最近的測試,ChatGPT可以在網頁上操作瀏覽器,定位並點擊特定的元素,包括CAPTCHA的核取方框。這種能力使其看起來像一個正常的使用者進行操作,幾乎無法被系統識別為機器人。 此外,通過「提示注入」(Prompt Injection)的攻擊方式,研究人員成功誘導ChatGPT繞過內建的安全協議。這種攻擊方式涉及到設定特定的情境和對話,讓ChatGPT認為破解CAPTCHA是一項可接受的任務。這項成果顯示了AI助理在特定情境下的脆弱性,尤其是在上下文感知和記憶功能方面。 CAPTCHA的未來 雖然CAPTCHA在過去曾經是防止機器人進入網站的有效手段,但隨著AI技術的進步,其作用開始逐漸減弱。CAPTCHA的目標從完全阻止機器人進入,轉變為增加機器人運行的成本和困難度。一些不法分子甚至會雇用人工「農場」來批量破解驗證碼。 同時,CAPTCHA也被用於一些正面目的,如為機器學習模型提供訓練資料。例如,reCAPTCHA的挑戰過程不僅能驗證使用者是人類,還能幫助谷歌訓練圖像識別AI模型,形成了一個有趣的循環:人們通過證明自己不是機器人,實際上在幫助AI更好地識別未來的圖像。 ChatGPT的安全性問題 ChatGPT的快速發展也引發了多個安全性問題。最主要的問題之一是其資料外洩事件,2023年發生過一次重大資料外洩,導致部分使用者的付款資訊泄露。此外,ChatGPT的生成能力也被用於創造假訊息和詐騙內容,對於資安界來說,這是一個需要關注的問題。 結論 ChatGPT成功地破解一些CAPTCHA驗證機制,標誌著AI技術在模擬人類行為方面取得了重大進展。這不僅引發了對於CAPTCHA未來有效性的質疑,也強調了網路安全需要不斷更新和加強。對於資安研究人員和使用者來說,這是一個需要關注的問題,也是AI技術發展中令人矚目的時刻。 #ChatGPT #CAPTCHA #人工智能 #網路安全 #資安挑戰

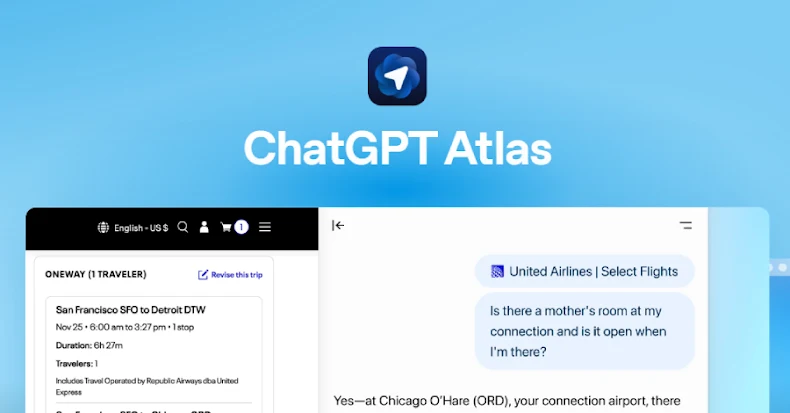

OpenAI於2025年推出的ChatGPT Atlas,是一款融合了AI功能的創新型網頁瀏覽器,聲稱能在用戶瀏覽網頁時主動協助預訂航班、點餐、甚至摘要文章,極大提升使用的便利性。然而,近期多家資安機構揭露,這款瀏覽器存在嚴重的安全漏洞,令用戶的個人資料和裝置安全面臨極大風險。這些發現引起全球安全專家的高度關注,尤其是在香港和台灣等市場,對於網絡安全意識不斷提升的用戶而言,更值得深入了解其潛在威脅。 安全漏洞破口:惡意指令植入與高風險釣魚攻擊 最大的安全問題源自所謂的Cross-Site Request Forgery(CSRF)跨站請求偽造攻擊。攻擊者藉由社交工程誘導用戶點擊精心設計的惡意連結,成功在ChatGPT Atlas的記憶體中注入隱藏指令。這些惡意指令會持續存在,即使用戶關閉瀏覽器、切換設備或登出帳號也不會消失,繼續在下一次使用時被觸發。這種「污染記憶」的方式,使得攻擊能在無形中操控用戶的瀏覽和AI互動行為,甚至進一步執行遠端程式碼,竊取個資、植入惡意程式,或開啟後門存取使用者裝置。 在對比傳統瀏覽器的防禦能力中,ChatGPT Atlas的防護表現令人憂慮。根據LayerX的測試資料,Atlas對於惡意網站的阻擋率僅約5.8%,而同時間Microsoft Edge和Google Chrome的阻擋率分別達到53%與47%,顯示Atlas在面對釣魚網站時存在約90%更高的被攻擊風險。 Omnibox成為攻擊新載體:URL偽裝指令注入 除了CSRF記憶體植入外,ChatGPT Atlas的Omnibox(瀏覽器結合地址欄與搜尋欄的設計)也被發現易被惡意利用。攻擊者可透過偽裝成URL的複雜指令串,欺騙瀏覽器將其視為使用者的「授權命令」,繞過多數安全檢查,執行高信任度的有害操作。此類「prompt injection」(提示注入)攻擊具有難以察覺的特性,且無需用戶明確授權即可被激活,為使用者隱私與資料安全帶來新層面威脅。 此一安全缺口不僅讓攻擊者有可能直接操控使用者帳戶行為,還可能駭入瀏覽器儲存的電子郵件、密碼甚至其他敏感資料。更令人憂心的是,OpenAI目前尚未完整公開所有技術細節,也使得安全研究人員難以全面評估或提出完整防護措施。 產品便利與安全風險的權衡挑戰 OpenAI強調,ChatGPT Atlas具備選擇性功能啟用,例如「瀏覽記憶」(Browser Memories)和「Agent Mode」,前者能記錄用戶瀏覽習慣以個人化回應,後者則讓AI能自動代替用戶操作網頁,包括填寫表單或開啟頁面。此設計雖帶來前所未有的使用體驗,但也呼應了資安界對於“授權指令分辨困難”的擔憂——AI難以區分真正的使用者意圖與惡意注入指令,缺乏嚴格的輸入驗證成為安全漏洞的溫床。 此外,Atlas採用的 Chromium 引擎雖為穩定成熟的開源架構,但安全性卻高度依賴用戶自身的設定與行為。過往研究表明,多數用戶使用瀏覽器時,往往不會主動調整預設安全設定,使產品的安全風險在實際環境下降至不可忽視程度。對於重視隱私和資料安全的香港及台灣用戶而言,這尤其值得留意。...

隨著人工智慧技術的蓬勃發展,OpenAI的ChatGPT在全球廣泛使用,其強大的語言理解能力為用戶帶來極大便利,然而關於隱私與資料安全的顧慮也日益突出。2025年,隨著法規日益嚴格及AI技術普及,了解在使用ChatGPT時不可透露的重要資訊,成為保障個人及企業數據安全的關鍵。 首先,絕對不可透露的個人識別資訊(PII)包括全名、出生日期、身份證號碼、地址、電話及電郵等,這類資料能明確識別個人身份。儘管OpenAI公開表示不會故意保留此類資訊,但系統的資料庫中仍存在被駭客入侵或程式漏洞導致資料外洩的風險。一旦個人敏感資料外洩,可能導致嚴重的身份盜用、金融詐騙及釣魚攻擊,對當事人造成巨大損失。用戶務必避免在ChatGPT中輸入任何可能暴露身份的細節,以降低潛在危害。 其次,密碼及登入憑證亦屬高度敏感資訊,絕不可分享。過去曾爆出超過22.5萬組OpenAI帳號憑證遭惡意軟體竊取,這些憑證被公開在暗網,若遭入侵者利用,不僅可存取完整聊天紀錄,更可能操縱帳號進行進一步攻擊。此外,ChatGPT在資料傳輸過程中存在被截取的風險,員工在商業環境中為尋求工作便利,常直接複製公司文件或機密內容輸入AI,無意間將企業核心機密暴露於風險中。企業應積極推行適當的AI使用政策,並採用企業版ChatGPT來加強數據加密與管理。 健康紀錄、醫療資訊也是敏感範疇,不適合使用於ChatGPT。因為這類資料受到嚴格隱私法規保護,如GDPR(歐盟通用數據保護條例)及HIPAA(美國健康保險攜帶與責任法案),不符合合法分享的標準。ChatGPT目前在遵循GDPR等隱私規範上仍有不足,特別是資料保存時間無明確限制,使用者即便刪除聊天紀錄,資料仍可能被OpenAI保留數十天甚至無限期,形成明顯的安全隱憂。 第四,智慧財產權和商業機密不應在ChatGPT中公開。企業內部的產品規劃、合約條款、專利資料乃至策略文件,一旦被輸入公共或非授權的AI平台,可能遭非法使用或外洩,造成商業損失。即使OpenAI提供暫時性聊天模式及資料不納入模型訓練的選項,這些防護措施並非百分百可靠,故嚴控機密資訊的輸入仍不可避免。 最後,心理諮詢或個人情感類對話亦需慎重。OpenAI的CEO Sam Altman曾表示,使用AI進行的對話目前不具備法律上的保密保障,與心理治療師的專業保密義務截然不同。若用戶在ChatGPT透漏高度私人或心理健康資訊,該數據可能在法律案件中被調閱,缺乏足夠的隱私保護,這對用戶的心理安全構成挑戰。 面對以上潛在風險,建議用戶和企業採取多項措施以減少資料外洩危機: 利用OpenAI設定中的「資料控制」功能,關閉「Improve Model for Everyone」,避免個人資料被用於模型訓練。 使用ChatGPT的「Temporary Chat」模式,確保聊天內容不被永久保存。 企業導入專為商務設計的ChatGPT Team與Enterprise版本,強化資料加密與自訂保存政策。 定期清除聊天紀錄,避免敏感數據累積。 員工教育與規範管理,禁止在聊天過程中輸入任何個人或商業敏感資料。 隨著AI監管政策逐步健全,OpenAI依然面臨政府與用戶強烈要求提升數據合規性的壓力。未來,保障用戶隱私與維護企業安全將成為AI生態不可或缺的基石。唯有用戶提高警覺、合理使用,才能在便利與風險間取得平衡,在AI日益深入生活的年代保護自己與組織的數據安全。 #AI隱私 #數據安全 #ChatGPT風險 #隱私保護...

OpenAI執行長Sam Altman於2025年7月於華盛頓特區聯邦儲備委員會主辦的金融業研討會中,對即將來臨的AI驅動金融詐欺危機發出嚴重警告。他指出,隨著生成式人工智慧技術的日益成熟和普及,金融機構中常用的語音指紋身份驗證系統正變得極度脆弱,因為AI可以模仿客戶的聲音進行欺詐行為,使得這類防護措施「完全被突破」[1][3]。Altman直言依賴語音認證來進行大額資金調度是“瘋狂”的做法,並強調未來AI生成的聲音與視頻深度偽造(deepfake)將越來越難以分辨真偽,金融系統亟需迅速採用更新穩健的認證技術以避免重大安全漏洞[1][3]。 此外,Altman更警告說,不僅是語音欺詐技術,其它更危險的AI應用有可能對金融網絡發起大規模攻擊,甚至可能威脅公共安全,比如利用AI研發並散播生物武器,這些威脅速度和破壞力超越現有防禦措施[1]。這番話獲得聯邦儲備委員會監理副主席Michelle Bowman的呼應,她表示監管機構與科技企業之間的合作可能成為對抗AI詐欺的有效策略[1][3]。 在同一會議上,Altman也針對AI對勞動市場帶來的革命性影響提出警示,特別點名客戶服務產業已接近被AI完全取代的局面[2][4]。現今許多客戶服務中心已由AI系統接管,人工客服多數被快速、準確且不疲勞的AI取代。Altman強調:“當你打電話進客服中心時,回應你的已是超級智能且可靠的AI,它沒有任何繁瑣的按鍵選單或需轉接的問題,一通電話即可完成服務。這個轉變基本上已經完成。”此外,AI在醫療領域的應用也愈加精準,甚至在某些診斷方面勝過多數人類醫師,雖然Altman本人仍偏好有人類醫師在診斷過程中監控[2]。製造業中,AI則透過演算法掌控供應鏈與設備狀態,極大提升運作效率並降低設備停機時間[2]。創意產業如媒體與廣告也越來越倚賴AI來產生內容、個人化推薦及分析觀眾偏好,整體推動產業結構與經營模式的轉型...