OpenAI 收購 Convogo 團隊:AI 雲端與主管教練工具的關鍵一役 OpenAI 收購高階主管教練 AI 工具 Convogo 背後的團隊,再次把「acqui-hire 人才併購」與「AI 雲端平台」推上焦點。這不只是另一宗 AI 產業併購,而是大模型公司如何搶占企業級應用入口的縮影,尤其是在領導力發展、HR 科技與顧問服務這三大場景。 Convogo 的產品聚焦高階主管教練與顧問市場,協助自動化領導力評估、回饋報告與相關文字工作。如今產品將被陸續關閉,而核心團隊則轉向為 OpenAI 打造 AI 雲端能力,這個轉折本身就說明了產業優先順序正在改寫。 為何 OpenAI...

美國一名聯邦法官近日裁定,馬斯克控告OpenAI的訴訟可以進入正式審判程序,而不是在程序階段即遭駁回。 這起「馬斯克控告OpenAI」的案件,表面上是創辦人決裂與股權爭奪,實際上卻是一場關於 AI 未來治理模式的公眾公投:究竟「非營利使命」能否在龐大的資本與權力壓力下存活? 在生成式 AI 爆炸成長、各國監管仍追趕不及的此刻,這宗訴訟為產業敲響了一記警鐘:AI 創新若完全交給董事會與投資人決定,社會能否接受其外部成本與風險? 馬斯克控告OpenAI:不只是私人恩怨 這場訴訟的核心,是對「非營利轉營利」的強烈質疑。指控的主軸可以概括為三點: 當初以「非營利、造福人類」為號召,吸引捐助與人才加入 隨著技術突破與商業機會浮現,組織結構逐步轉向營利導向 重大商業合作與資本挹注,讓外部投資人與合作夥伴取得實質影響力 從外界角度來看,這起OpenAI訴訟不只關乎合約條款是否被違反,更關乎一個根本問題: 當 AI 實驗室從「為公益」轉向「為獲利」時,原本對社會做出的承諾,還算數嗎? 非營利轉營利,引爆的三大結構性爭議 1. 公共利益 vs 股東利益:誰說了算? AI 的特殊之處在於,它同時是:...

在AI時代,教育現場正經歷前所未有的震盪。生成式AI與ChatGPT等工具,不只改變學生寫作業的方式,也正在重塑老師教學、評量與學術誠信的基本規則。 AI時代下的教育:當「完美作業」變成警訊 過去,數位學習代表的是線上選課、下載教材、利用搜尋引擎蒐集資料,學生仍需花時間閱讀、整理與消化資訊,老師也能從作業風格與錯誤模式判斷學習狀況。 如今,生成式AI出現後,很多老師開始發現: 作業答案出奇一致、幾乎沒有錯字或計算錯誤 英文作文用字華麗,卻與學生平時口語或課堂表現明顯脫節 報告架構完整,但缺少個人觀點與原創思考 這些「近乎完美」的作業,不再是值得高興的成就,而是師生互信被動搖的警訊。老師不知道該相信誰的努力,學生也擔心被誤判作弊,雙方都在不安中前進。 學生用ChatGPT寫作業:偷懶,還是新型學習? 討論AI教育時,一個最常見的問題是:「學生用了ChatGPT,是不是代表不用讀書了?」 事實上,學生使用AI的動機與方式非常多元: 為了「趕作業」:把題目貼進去,直接複製答案 為了「查觀念」:請AI用簡單文字解釋艱深概念 為了「整理資訊」:讓AI彙整長篇資料、幫忙抓重點 為了「潤飾語言」:請AI改寫句子、修正文法 問題不在於學生是否使用AI,而在於: 他們是否仍有「自己思考」? 他們是否能分辨AI回答的錯誤與偏誤? 他們是否清楚在何種情境下,使用AI已經違反學術誠信? 近年有調查顯示,使用AI聊天機器人完成作業的青少年比例在短時間內幾乎翻倍成長,這代表「AI輔助學習」已成新常態。若教育仍假裝這件事不存在,只會讓誠實面對工具的學生處於不利位置,讓偷偷使用的人繼續鑽漏洞。 老師用AI備課:被取代,還是升級? 在另一端,許多老師也開始用生成式AI備課、出題、整理教材: 請AI根據課綱產生練習題與解答 要AI幫忙設計生活化的數學情境題...

用AI出貓正迅速成為香港學界的新難題,尤其在口試與寫作評核上愈演愈烈。當學生利用生成式AI寫演講稿、作文甚至整份報告時,老師與同學面對的,不只是一次單純的作弊事件,而是一場關於信任、公平與教育方向的大考驗。 為何學生愈來愈傾向用AI出貓? 在不少家長和老師眼中,「用AI出貓」似乎難以理解,但對學生來說,這往往只是「順手一試」的選擇。背後有幾個關鍵原因: 工具極度易得:智能手機、平板、家中電腦隨處可見,只要輸入題目,AI便能在幾秒內生成完整演講稿或文章。 學業與評分壓力沉重:呈分試、升中派位、校內排名等壓力,令部分學生寧願鋌而走險,以「靚分數」為首要目標。 對AI出貓的道德感模糊:不少學生會認為:「我只是用AI幫手改寫,不算抄襲。」這種灰色地帶令紀律教育更具挑戰。 家長與老師對AI理解不足:成年人本身對AI工具的掌握有限,更難向子女清楚解釋「何謂合理使用、何謂作弊」。 當上述因素交織,「用AI出貓」便從個別學生的秘密行為,逐漸變成班級之間口耳相傳的小道「攻略」。 口試與演講評核:AI出貓最易「出事」的場景 語文說話評估、演講考試,本來是要測試學生的語言組織、即場表達與臨場反應。但在AI盛行的年代,以下幾個風險急速上升: 有學生提早得知題目,用AI生成完整演講稿再背誦。 有學生在候考期間偷用手機,輸入題目後即時取得「完美稿」。 老師若未有嚴密監察與清楚規範,很難第一時間察覺內容是否「人手」或「AI製造」。 一旦有人用AI出貓被揭發,學校為維持評核公平,很可能只能選擇「全班重考」。在未有成熟處理機制之前,這種集體後果往往會產生幾重副作用: 守規矩的學生感到極度不公平 班級氣氛轉趨緊張與對立,互相猜疑 家長對學校判斷與安排提出質疑 這些看似只是一宗學校紀律個案,其實折射出整個制度對AI時代準備不足的脆弱。 AI出貓與傳統作弊有何不同? 有人會問:用AI出貓,不就是另一種「抄答案」嗎?事實上,兩者有幾個關鍵差異: 1. AI是「隱形槍手」 傳統作弊常見的是: 把小抄帶入考場...

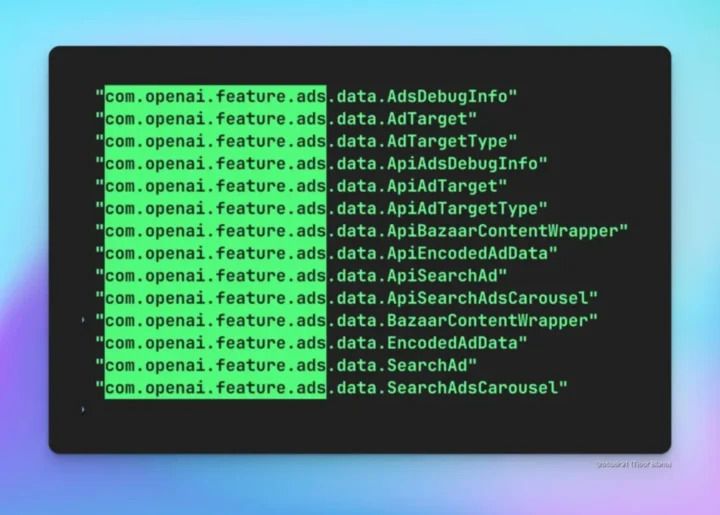

生成式 AI 時代的「ChatGPT 廣告」難題:便利、金錢與信任的三角拉扯 生成式 AI 正在成為新一代網絡入口,而「ChatGPT 廣告」這個關鍵字,已經不再只是遙遠的想像。當聊天機械人從實驗玩具變成日常基礎設施,如何變現、是否應該加入廣告,以及廣告會如何改變我們獲取資訊的方式,正在成為產業與用戶都無法迴避的現實問題。 ChatGPT 廣告:從理想訂閱制走向混合模式 早期的生成式 AI 服務,喜歡把自己包裝成「高級訂閱工具」: 你付月費,我給你乾淨、不被廣告干擾的體驗。 但隨著模型變大、用戶暴增、雲端運算與 GPU 成本居高不下,單靠訂閱費支撐一切變得愈來愈困難。 於是,以下幾個現實因素開始推動「ChatGPT 廣告」模式浮上檯面: 推理成本(Inference cost)仍非常昂貴:每一次對話背後都是大量運算,即使成本逐年下降,用戶一多仍然是天文數字。 免費用戶占比高:多數人習慣免費使用,真正願意付費的比例往往只是少數菁英或重度使用者。 投資人期望現金流:燒錢換增長可以撐一陣子,但不能永遠,最現實的收入模式仍然是廣告與電商分成。 結果是:...

真人社群媒體正成為科技業下一個高風險賭注。當充斥機器人帳號與假內容的社群平台逐漸失去信任,主打「只允許真人」的新一代社群服務,開始被視為重建網路信任的可能解方。 為何「真人社群媒體」突然變得重要? 近兩年,社群平台正面臨三個同時惡化的問題: – 機器人帳號與假帳號失控成長 – 由 AI 生成的內容難以分辨 – 使用者對演算法與平台決策的信任急速下滑 傳統做法多半只是強化「風紀股」功能:下架內容、封鎖帳號、要求手機號碼與電子郵件驗證。但在生成式 AI 爆發後,這些手段已越來越無力。只要能買到一批門號或簡訊服務,機器人帳號就能源源不絕地被自動建立。 因此,「真人社群媒體」的核心不再是調整演算法,而是換一個根本邏輯: 不是問「這則貼文真的假的?」而是先問「發文的到底是不是人?」 生物特徵驗證:從「是真人」開始的社群設計 為了實現只允許真人的社群平台,最直接的技術路徑就是「生物特徵驗證」。也就是以人的臉部、虹膜等不可輕易複製的特徵,作為「這是一個真實個體」的憑證。 與傳統社群平台相比,兩者的邏輯差異明顯: 傳統社群平台 依賴手機、電子郵件、裝置指紋、行為模式 認證的是「一組帳號是否看起來像正常使用者」 容許一個人持有多個帳號,甚至完全匿名 真人社群媒體...

AI 安全準備正在成為生成式 AI 時代最關鍵的議題之一。當大型模型能力急速提升,企業開始意識到,沒有「AI 安全準備」的治理架構,商業野心隨時可能被安全事件與公關風暴吞噬。 為何 AI 安全準備升級為高階主管職位? 當一家領先的 AI 公司公開對外招募「Head of Preparedness(準備度負責人)」這樣的高階主管時,真正釋放出的訊號是: AI 風險不再只是法遵或研究部門的小題目,而是攸關企業存亡的核心戰略。 這類職位的核心任務,通常涵蓋: 盤點前沿 AI 能力帶來的新型風險 從電腦安全到生物風險建立跨領域風險地圖 持續監測模型是否開始展現自我改進、自我強化等高風險跡象 評估 AI 對使用者心理健康與社會穩定的潛在衝擊...

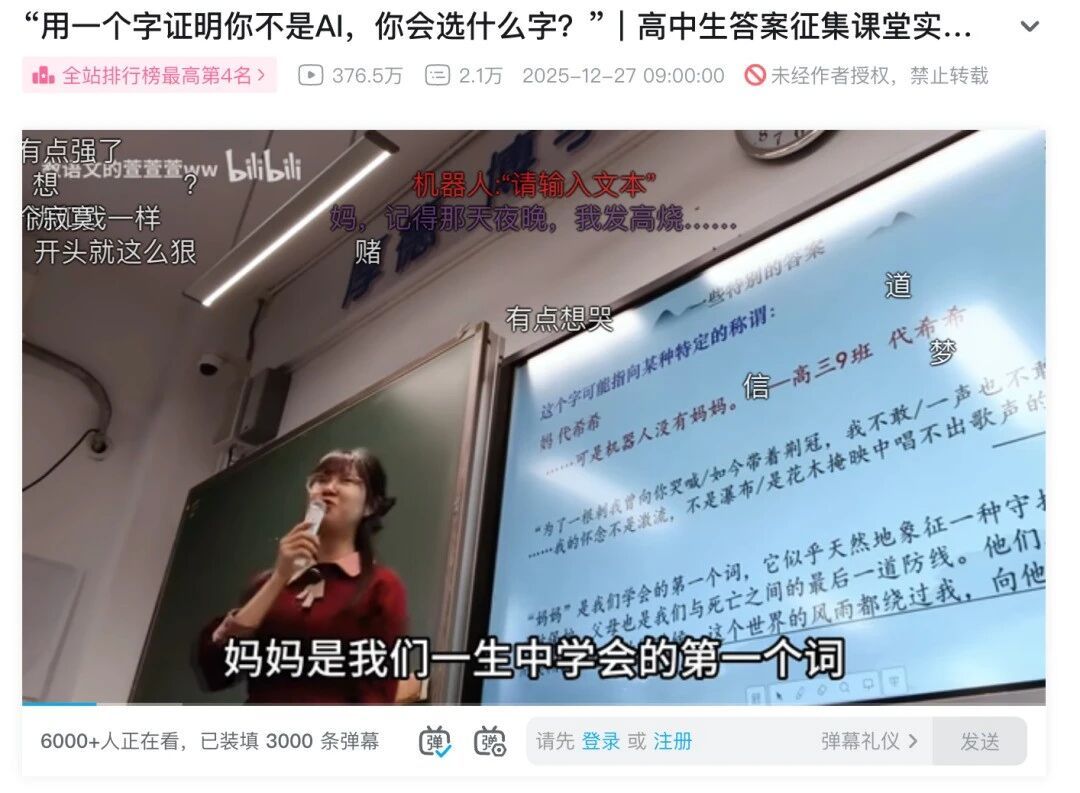

在生成式人工智慧快速滲透的今天,「用一個字證明你不是AI」這樣的提問之所以在網路上流傳,背後其實是我們對人性價值的集體焦慮與追問。當你認真思考要選哪一個字,等於在重新界定:在人與AI之間,什麼才是真正不可被複製的差異。 用一個字證明你不是AI:為何這個提問刺中人心 從語文課、社群平台到各種討論場合,「用一個字證明你不是AI」迅速變成一種時代小測驗。它看似遊戲,卻有幾個關鍵特點: 逼你在最小單位里,濃縮對「人」的理解 不是問專業技能,而是問情感與存在 不是考知識,而是考生命經驗 真正有趣的是,人們給出的字,往往不是「智」「算」「腦」這類和能力相關的詞,而是圍繞情感、關係、時間感與不完美展開。這本身,就是對AI時代最溫柔也最倔強的回應。 人類與AI的差異:不在算力,而在人性的重量 AI可以在幾秒鐘完成寫作、翻譯、繪圖,甚至模仿人的語氣與風格,但它依然缺少幾個關鍵維度: 害怕失去的恐懼 無法預測的情緒起伏 因牽掛而被拉長的時間感 為了毫無功利的理由而停下腳步 當人們試圖用一個字證明自己不是AI時,真正被強調的,往往不是高效,而是那種「明明低效、卻又無可替代」的人性。 「媽」:被守護與面對死亡的勇氣 很多人第一反應會選「媽」這個字,理由看似簡單:AI沒有媽媽。但這個選擇其實指向更深的東西—— 第一個喊出口的稱呼,往往連結著安全感 父母像是一道擋在我們與死亡之間的防線 當那道防線不在,人開始真切面對有限的人生 AI不會在醫院病房門外徹夜守候,不會在父母老去時被迫學會堅強。血緣、依戀、失去,構成了人類情感最深的斷層線,也勾勒出「媽」字背後難以言說的重量。 這種重量,無法用任何演算法訓練出來,只能靠一次次真實的心痛積累。 「急」與「慢」:人類對時間的主觀拉扯 如果要再用一個字證明你不是AI,有人會選「急」。例如: 在醫院等待檢查結果時,每一分鐘都像被拉長...

生成式 AI 正在快速滲入搜尋、辦公、購物與娛樂服務,然而真正該被討論的,是「AI 廣告攔截器」何時出現,而不是哪個聊天機器人最聰明。當 AI 廣告與個人化推薦緊密綁在一起,誰能替使用者擋下不透明的商業影響力,將成為 2026 年之後的關鍵議題。 大模型燒錢現實:AI 廣告為何幾乎無可避免? 生成式 AI 看起來像雲端服務,但本質更接近「隨用隨燒」的超級電廠。每一次提問背後,都對應到昂貴的 GPU、龐大的電力與資料中心維護成本。 過去兩年,產業一度相信: – 用戶訂閱制(例如每月固定付費) – 企業 API 計價 可以支撐大多數生成式 AI 的營運。但很快就發現幾個殘酷事實:...

人工智能(AI)已經不再只是工程師或研究人員的專利。無論你是上班族、學生、創作者,甚至只是單純對 AI 感到好奇,2026 年正是入門學 AI 的最好時機。 但問題是:👉 網上 AI 課程那麼多,新手應該從哪裡開始?👉 有沒有 不用寫程式、又免費、又講得清楚 的選擇? 以下精選 8 個真正與 AI 相關、而且適合入門新手的免費課程,涵蓋「AI 概念理解」、「生成式 AI 應用」、「ChatGPT 使用」、「AI 協作工作方式」等實用主題。 1️⃣...

AI 兒少保護的新門檻:ChatGPT 年齡預測 功能代表什麼? ChatGPT 年齡預測 功能的推出,標誌著生成式 AI 進入一個更重視兒少保護的新階段。當聊天機器人越來越像「24 小時不下線的陪伴者」,平台是否有能力分辨對方是 13 歲還是 30 歲,就不再只是產品細節,而是直接關係到未成年用戶的安全與心理健康。 在這樣的背景下,用 AI 來預測使用者年齡,並據此啟動不同強度的內容過濾與安全保護機制,已經成為大型平台不得不面對的現實選擇。 為何生成式 AI 需要「年齡預測」來保護未成年用戶? 生成式 AI 的對話能力愈來愈強,孩子在深夜與 ChatGPT...

OpenAI 認證正成為企業縮短 AI 技能差距的關鍵工具。面對生成式 AI 的爆炸性成長,OpenAI 推出全新的 AI 認證標準與 AI Foundations 認證課程,目標是在 2030 年前為 1,000 萬名美國勞工建立可驗證的 AI 能力,正面迎戰「AI 技能差距」問題。 為何 OpenAI 要用認證來解決 AI 技能差距?...