近期香港接連出現兩條令人不安、但又極具「時代代表性」的新聞主線:一邊是大學校園出現疑似以 AI 合成方式製作「不雅影像」的爭議(俗稱「港大 AI 裸照事件」);另一邊是私隱專員公署(PCPD)首次在更宏觀層面,正式推出「給學校及家長」的深偽應對指引,明確提出:校方應盡量避免對外發布清晰可辨識的學生影像、家長亦要審慎上傳子女照片。 很多人第一反應都係:「咁係咪即係『唔好影相』、『唔好貼相』就解決?」但如果你把這件事當成單一的道德問題、或單一的法例漏洞,你會錯過它真正的核心:AI深偽令『影像』由紀錄變成武器;而學生私隱,已由「資料保護」升級為「人身安全與尊嚴」的議題。 以下我會用「按時序」先講清楚事件脈絡,再用幾個角度深入拆解:技術風險、校園制度、家長與平台責任、以及法律如何(未必)追得上。 一、事件時序:由校園爭議,到私隱署推出「家校錦囊」 1)校園事件曝光:AI 合成不雅影像引發社會震盪 「港大 AI 裸照事件」之所以引爆,是因為它把一個本來抽象的科技詞(AI DeepFake(深偽)),瞬間變成最具羞辱性、最具破壞力的現實情境:在未經同意下,利用他人照片作為原材料,生成帶有性意味或露骨內容的偽造影像。 即使你未掌握每一個細節,你都會感受到其中的恐懼:在 AI 時代,「一張普通合照」可能不再只是回憶,而是被移花接木、再創作、再散播的素材。 2)調查與公眾質疑:為何「難跟進」? 其後私隱專員公署曾表示因證據與合作因素而出現調查困難,並出現「暫停/終止跟進」的結果。這一點令不少市民感到無力:明明侵害感真實存在,為何制度上卻可以走到「證據不足」這一步? 這裡先留一個伏筆:因為深偽的本質,往往令「證據」與「責任」變得更難固定——尤其當內容未必公開散播、或受害人出於創傷與二次傷害顧慮而不願現身。 3)私隱署轉向「預防治理」:發布官方家校指引 就在這個背景下,私隱公署在 2025 年...

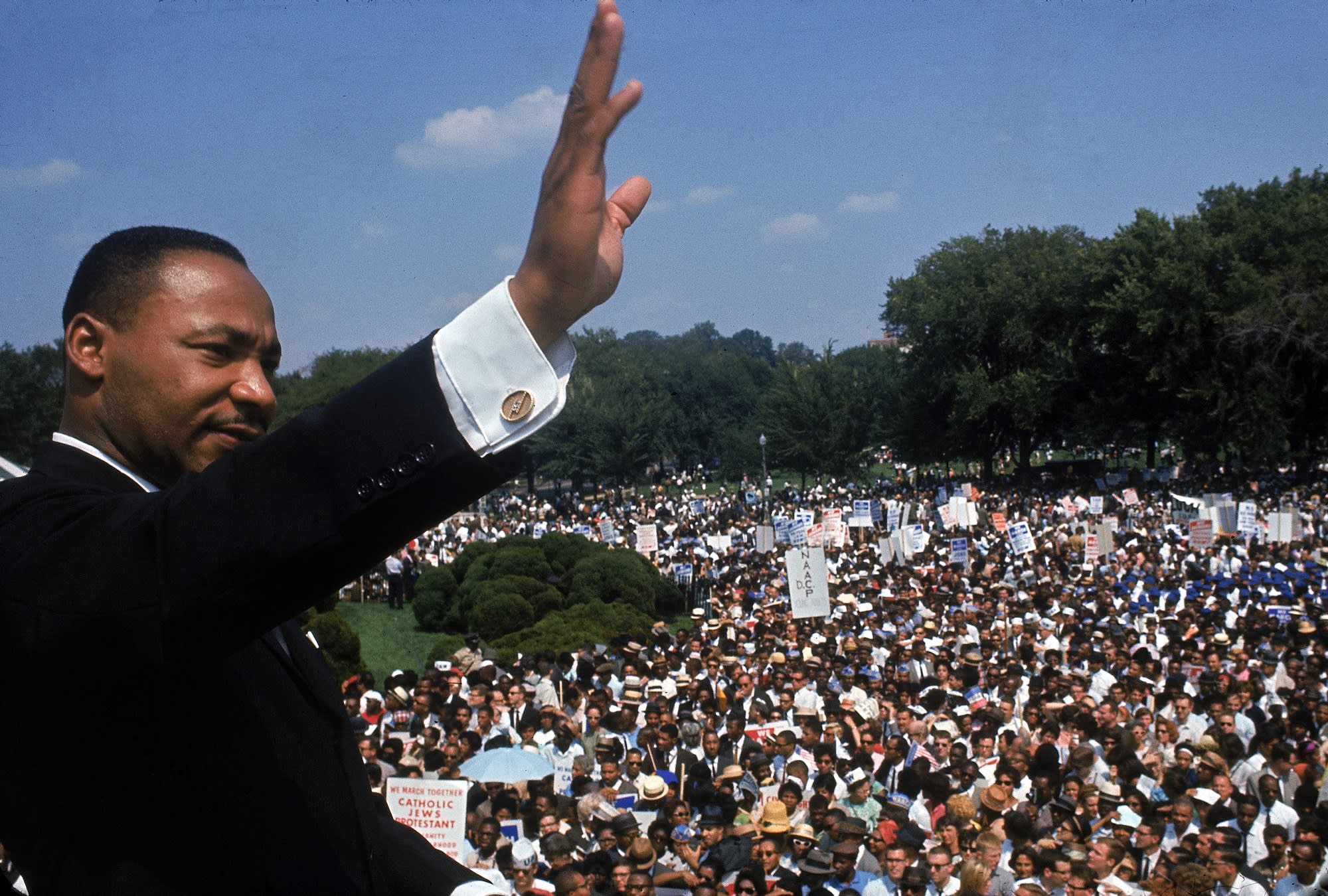

近期,OpenAI 的應用程式 Sora 2 引發了爭議,因為用戶利用該軟體生成的深偽影片(deepfakes)包含了 馬丁·路德·金 (Martin Luther King Jr.)的模樣。這些影片被描述為「不尊重且斷裂的」描繪,引起了金博士的女兒 Bernice A. King 的強烈反對。為應對這次事件,OpenAI一度暫停了使用者創建馬丁·路德·金的深偽影片功能,並表示將加強監管,確保公眾人物的肖像使用符合道德標準。 這次事件反映了在數字時代,人工智能技術的應用和對公眾人物肖像的使用存在的複雜性及其倫理問題。OpenAI 公司在聲明中強調,公眾人物及其家屬應該對自己的肖像使用有最終控制權。這一立場表明了對於保護公眾人物肖像權益的重視。 Sora 2 應用程式的熱門度在於它能夠生成名人和網紅的深偽影片,但這也引發了對深偽技術可能造成的影響的關注。特別是在使用躺在床上的名人的肖像來創作幽默或娛樂內容時,社會開始反思這種行為的倫理界限。如今,OpenAI 對於這一事件的應對不僅是為了滿足金氏家族的要求,也代表了對人工智能應用倫理的思考和調整。 此外,這次事件也引發了對於資訊技術快速發展對社會的影響的討論。深偽技術 的進步使得任何人都能輕易生成看似真實的影片或圖像,往往會混淆真偽,造成社會的混亂。因此,如何在維護言論自由的同時,保護相關個人的權益和尊嚴,成為一個需要深入思考的問題。 對於這些創新技術的監管和倫理考量,目前的進展顯示了行業對於這些問題的重視。未來,隨著技術的進一步發展,相關的倫理和法規將需要持續更新和完善,以確保這些技術能被妥善應用於社會。 最後,隨著人工智能技術的不斷進步,對於其應用和監管的思考將會更加重要。如何在保持創新活力的同時,確保個人的權益和社會的秩序,將是未來發展的關鍵課題。...

近年來,隨著人工智能(AI)技術的快速發展,深度偽造(deepfake)語音詐騙已成為一大安全威脅,尤其在香港與台灣等地,相關詐騙案件呈現爆炸性增長。這種詐騙利用AI進行聲音克隆,能以極高的相似度模仿目標人物,是犯罪集團實施社會工程攻擊的新利器,造成極大的財務損失與信任危機。 首先,該類詐騙的核心技術是AI語音克隆,只需15至30秒的目標聲音樣本,例如來自社交媒體、公開影片甚至語音留言,即可透過如Eleven Labs、Speechify和Respeecher等工具製作出逼真的語音深度偽造。這種技術不僅模仿聲音音色,還可根據需求即時生成各種語句,令詐騙電話或錄音聽起來真實可信,騙子會冒充受害人親友或高階主管,聲稱遇到緊急狀況,如被綁架、急需保釋金或公司財務轉帳等,迫使對方匆忙轉賬。 統計數字令人震驚。2024年,全球聯絡中心的深度偽造詐騙活動暴增680%,詐騙嘗試也增加26%。保險業合成語音詐騙更飆升475%,零售聯絡中心中平均每127通電話就有1通為詐騙電話。至2025年上半年,深度偽造相關詐騙案件激增,全球累計損失高達8.97億美元,其中4.1億美元於今年上半年發生,幾乎是去年全年的四倍。 此類技術威脅之大,不僅限於普通民眾。2024年,一宗香港跨國企業財務人員因收到多段由深度偽造聲音與視頻組成的指令,誤以為是高層主管親自操作而匯出超過2,500萬美元,成為本地深偽詐騙的著名案例。此外,美國國務卿Marco Rubio的聲音也被偽造成電郵語音留言,試圖竊取敏感信息,儘管未成功,但凸顯深度偽造技術已被高度惡意利用。 傳統的身份驗證方法如知識問題驗證(KBA)及一次性密碼(OTP),對抗這種假聲偽裝的效果日益有限。研究指出,53%的詐騙者能通過KBA驗證,四分之一能通過OTP挑戰,甚至16%的案件涉及來電顯示偽造。專家建議組織及企業必須導入多因素驗證、活體檢測(real-time liveness detection)和風險評分,以加強防護。 面對這些威脅,防範措施必須同時注重個人和企業層面。在個人層面,應保持警覺,降低在公開平台分享語音錄音的頻率,因為詐騙者往往從TikTok、Instagram等社交媒體蒐集素材。家人與親友間亦需相互提醒,確保遇到緊急求助電話時進行多重核實,避免因情緒驟變而上當受騙。企業層面則應加快升級安全系統,利用多樣化的認證方式,以及加強員工教育和風險識別訓練。 除了語音深度偽造,AI技術還被用於生成極具欺騙性的電子郵件(phishing)、短訊(smishing)及AI驅動的社交媒體機械人操控,這些手法與深度語音詐騙相輔相成,共同推高詐騙的複雜度與嚴重性。專家預估,到2025年深度偽造詐騙可能再增長162%,聯絡中心詐騙損失將觸及445億美元,而零售業遭受的詐騙率可能翻倍至每56通電話就有1通詐騙案件。 總結而言,隨著AI語音克隆和深度偽造技術日益成熟與普及,這類詐騙正快速滲透至個人、企業甚至政府層面。防範之道在於提升認知、強化技術防護及跨部門合作。唯有用科技反制科技,並培養全民防詐意識,才能在這波AI詐騙浪潮中守護自身利益,減少社會損失。 #深度偽造 #AI語音克隆 #詐騙防範 #聯絡中心安全 #人工智能安全