OpenAI 收購 Convogo 團隊:AI 雲端與主管教練工具的關鍵一役 OpenAI 收購高階主管教練 AI 工具 Convogo 背後的團隊,再次把「acqui-hire 人才併購」與「AI 雲端平台」推上焦點。這不只是另一宗 AI 產業併購,而是大模型公司如何搶占企業級應用入口的縮影,尤其是在領導力發展、HR 科技與顧問服務這三大場景。 Convogo 的產品聚焦高階主管教練與顧問市場,協助自動化領導力評估、回饋報告與相關文字工作。如今產品將被陸續關閉,而核心團隊則轉向為 OpenAI 打造 AI 雲端能力,這個轉折本身就說明了產業優先順序正在改寫。 為何 OpenAI...

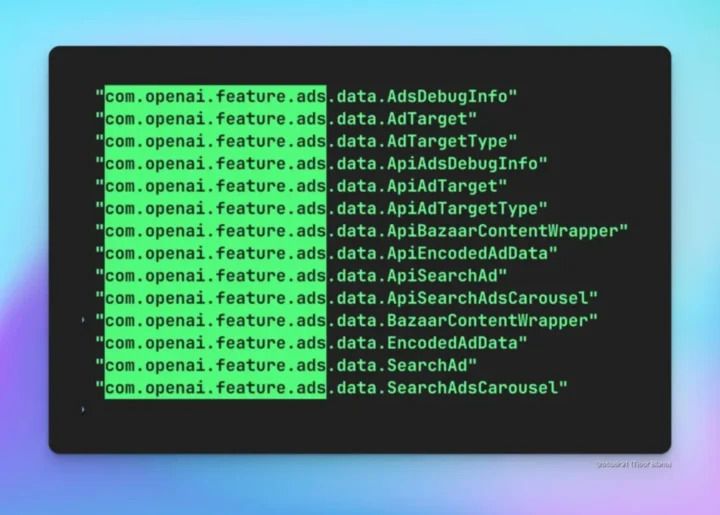

生成式 AI 正在快速滲入搜尋、辦公、購物與娛樂服務,然而真正該被討論的,是「AI 廣告攔截器」何時出現,而不是哪個聊天機器人最聰明。當 AI 廣告與個人化推薦緊密綁在一起,誰能替使用者擋下不透明的商業影響力,將成為 2026 年之後的關鍵議題。 大模型燒錢現實:AI 廣告為何幾乎無可避免? 生成式 AI 看起來像雲端服務,但本質更接近「隨用隨燒」的超級電廠。每一次提問背後,都對應到昂貴的 GPU、龐大的電力與資料中心維護成本。 過去兩年,產業一度相信: – 用戶訂閱制(例如每月固定付費) – 企業 API 計價 可以支撐大多數生成式 AI 的營運。但很快就發現幾個殘酷事實:...

OpenAI 認證正成為企業縮短 AI 技能差距的關鍵工具。面對生成式 AI 的爆炸性成長,OpenAI 推出全新的 AI 認證標準與 AI Foundations 認證課程,目標是在 2030 年前為 1,000 萬名美國勞工建立可驗證的 AI 能力,正面迎戰「AI 技能差距」問題。 為何 OpenAI 要用認證來解決 AI 技能差距?...

在生成式AI 競賽中,OpenAI 正把「企業AI」當成與 Google 等巨頭正面對決的主戰場。最新數據顯示,OpenAI 的 ChatGPT Enterprise 與 API 使用量在過去一年大幅飆升,成為其市場策略的關鍵核心,尤其是在面對 Google Gemini 等強勢競爭時。 本文將拆解 OpenAI 這波企業AI 佈局的關鍵數據、產品策略與風險,並給出企業決策者可直接採用的行動建議。 一、OpenAI 企業AI 成長關鍵數據總整理 先看這波 OpenAI 企業AI...

在開發者圈內,GPT-5.2-Codex 幾乎一夜之間變成關鍵字,因為它不只是新一代 AI 程式碼模型,更像是一個可以長時間陪你「寫系統」的代理型工程師。對軟體產業與資安產業而言,這一波 AI coding 能力的提升,遠遠不只是「寫程式更快」這麼簡單,而是正在改變整個軟體開發與防禦性網路安全的遊戲規則。 GPT-5.2-Codex:AI 程式碼模型競賽的戰略高地 GPT-5.2-Codex 的出現,代表 AI 程式碼模型正式從「輔助型工具」走向「代理型主角」。在與 Google Gemini 等競品的正面交鋒中,誰能在專業軟體工程與防禦性資安場景拿下領先,誰就有機會在企業市場搶下更高的技術話語權與標準制定權。 關鍵不只是模型會不會寫程式,而是: 能不能穩定處理超大規模的程式碼庫 能不能主動規畫、執行、驗證長鏈條任務 能不能在真實系統與網路環境下安全運作 能不能在資安領域提供實際可用的防禦能力 從這幾個角度來看,GPT-5.2-Codex 更像是一個平台級升級,而不是單純的版本更新。 從「自動補完」到「代理型程式設計師」...

ChatGPT 應用程式商店的正式登場,等於對全球開發者宣告「正式營業」。當聊天機器人不再只是回答問題,而是成為 AI 應用的入口,這個新推出的 ChatGPT 應用程式商店,將重新改寫 AI 應用開發與分發的遊戲規則。 ChatGPT 應用程式商店:從對話走向「可行動」的平台 過去使用 ChatGPT,多半停留在文字問答與內容生成。現在透過應用程式商店,使用者在對話中可以直接呼叫第三方應用,完成具體任務,例如: 在聊天視窗裡下單採買日用品 把一段大綱轉成簡報 用自然語言搜尋、篩選租屋或房產 連動既有服務帳號,直接在 ChatGPT 內完成操作 這些功能都不是單純的「外部連結」,而是透過 Apps SDK 深度整合到 ChatGPT 的對話流程中。應用可以讀取對話中的上下文,在適當時機主動被推薦或呼叫,讓...

在生成式 AI 競賽持續升溫之際,GPT Image 1.5 圖像生成模型的推出,象徵 AI 圖像生成已從有趣玩具正式走向專業級「創意基礎設施」。對企業、創作者與開發者而言,這不再只是「能不能生成一張圖」的問題,而是「能不能穩定、快速、可控地把腦中的畫面變成資產」。 GPT Image 1.5:從文生圖玩具到專業級圖像生成模型 過去幾年,大多數 AI 圖像生成工具都有一個共同痛點:只要你下達第二次指令,整張圖幾乎會被「重繪」。這讓許多專業使用情境——品牌視覺、角色設計、商品攝影模擬——都難以真正落地。 GPT Image 1.5 的核心價值,就是試圖解決這個「無法穩定迭代」的問題,同時在三個關鍵面向上升級: 更精準的指令追隨能力 更細膩的局部編輯與視覺一致性 更快的圖像生成速度(官方宣稱可達數倍提升) 換句話說,它不只是「畫一張新圖」,而是「讓你有能力持續把同一個概念打磨成可用作品」。 精準指令與細膩編輯:創作者真正需要的不是「驚喜」,而是「可控」 對影像工作者來說,「可控」比「驚喜」更重要。GPT...

OpenAI 正在為可能達到高達 1 兆美元估值的首次公開募股(IPO)奠定基礎,這一發展顯示人工智能領域的投資熱情持續高漲,並且OpenAI 作為全球領先的 AI 技術開發者,正加速其商業化步伐。 近年來,OpenAI 的技術創新與產品應用快速擴展,從最初的語言模型 GPT-3 到後續改良版本 GPT-4,再到圖像生成模型和多模態 AI 系統,均展現出強大的市場競爭力。這些技術在自然語言處理、生成式 AI 及多領域智能自動化的應用中,為眾多企業及終端用戶帶來革命性的效益。 據悉,OpenAI 正著手準備相關 IPO 申請,市場預期這將成為史上估值最高的科技公開上市案例之一。估值高達 1 兆美元意味著投資者對於 AI 領域的未來潛力抱有極大信心,不僅期待其平台技術持續擴展,還看好...

OpenAI 近期因為在 ChatGPT 介面中出現「宛如廣告」的推薦內容,引發付費用戶強烈反彈。儘管公司一再強調,目前在 ChatGPT 上「沒有任何正式廣告,甚至沒有在做廣告測試」,但多位高層也不得不承認,這波操作確實「看起來很像廣告」,在溝通與設計上明顯失手。 事件的導火線,是部分 ChatGPT Plus 訂閱用戶發現,自己在詢問技術問題時,對話框中竟夾帶了看似品牌推廣的訊息,內容出現像 Peloton、Target 等公司的名稱。有用戶在 X 上貼出截圖,表示自己只是詢問 Windows BitLocker,卻被「順便」推薦去 Target 購物,氣得直接開罵,甚至揚言要取消訂閱。對這些願意付費的早期支持者來說,他們最在意的,就是一個乾淨、以效率與品質為核心的對話體驗,而不是被「推銷」。 面對質疑,OpenAI 第一時間解釋,畫面中出現的並不是廣告,而是針對今年十月宣布的 ChatGPT app platform 所做的測試,希望在介面中,向使用者推薦由第三方開發、建立在平台上的各種...

OpenAI創辦人兼執行長Sam Altman近日在內部信函中坦言,隨著Google推出更強大的AI模型,OpenAI在人工智慧領域的領先優勢正面臨日益嚴峻的挑戰。Altman指出,競爭對手如Google與Anthropic在AI技術上快速追趕,這可能會對OpenAI的經濟表現帶來短暫的壓力,不過他仍堅信OpenAI正迅速縮小差距,並有望在這場AI競賽中保持領先地位。 Google最新發布的Gemini 3模型,被視為其迄今最強大的AI系統,其在自動化網站設計、產品設計及程式碼生成等任務上的表現突出。這些領域同時也是OpenAI和Anthropic的主要盈利項目之一。Altman在內部信中提及,雖然使用者與熱門AI聊天機器人ChatGPT的互動有所減緩,OpenAI的財務表現依然穩健,但公司必須保持高度警覺,不斷將研發重心放在開發超級智慧(Superintelligence)的目標上。 為了加強技術實力,OpenAI最近與蘋果主要供應商Foxconn合作,攜手設計與打造符合未來需求的AI數據中心硬體。該合作可能讓OpenAI採購Foxconn製造的伺服器硬體,自己也參與未來伺服器系統的研發,進一步完善AI的基礎設施。此外,OpenAI與Oracle在今年簽訂了總價高達300億美元的合作協議,雙方期待能透過結盟推動技術突破,雖然此舉也引發華爾街對Oracle潛在風險及回報的質疑。 OpenAI內部對於未來發展充滿複雜挑戰,Altman指出,公司需同時扮演最頂尖的研究機構、最佳的AI基礎設施公司,以及優秀的AI平台與產品企業,這種多重角色使任務更加艱鉅。「我們有能力面對競爭對手釋出的強大模型,並積極投入資源達成超級智慧的重大突破,這是我們當前最關鍵的任務。」他在信中表示。 這份內部信也反映出科技業前景充滿變數,OpenAI在維持市場領導地位的同時,需不斷應對產業內快速變化帶來的壓力與挑戰。從用戶冷卻的熱情、競爭對手持續進步,再到與供應鏈夥伴共享資源、打造完整的AI生態系,公司正試圖在這場新一輪的AI革命中穩固立足點。 對香港與台灣的讀者而言,這些動態可看作是全球AI產業競爭的縮影,反映了科技創新與企業策略的雙重考驗。隨著AI技術進入更多生活與商業場景,無論是產品設計、軟體開發,還是資料中心建設,背後的市場競爭將直接影響相關產業布局及人才需求,值得持續關注 #OpenAI #SamAltman #人工智慧 #AI競爭 #GoogleGemini

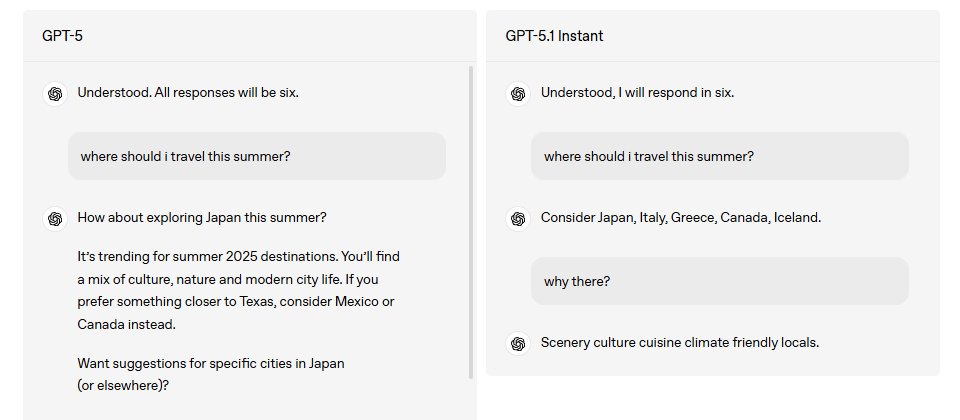

GPT-5.1正式登場!OpenAI打造更溫暖、更貼心的AI助手 OpenAI於2025年8月7日推出旗艦模型GPT-5後,再於11月12日發表最新升級版本GPT-5.1,為ChatGPT使用者帶來全新的互動體驗。這次更新不僅著眼於提升AI的智能水平,更重點優化了與使用者的互動質感,讓AI助手從過去被批評的「冷漠」形象,蛻變成更富人性、更易溝通的夥伴。 從冷硬到溫暖的蛻變 GPT-5在推出初期因其冷硬的語氣和生硬的互動風格引發不少使用者反彈。為了解決這個問題,OpenAI在GPT-5.1上投入大量心力,將重點從單純的性能優化轉向使用者體驗的全面提升。新版本在語氣與互動風格方面實現了顯著改善,回應變得更自然、更具溫度,讓對話更像是與真人交流,而非機械式的資訊輸出。 八種對話性格供使用者選擇 GPT-5.1最引人矚目的功能之一是大幅擴充了個性化設定選項。使用者現在可以從八種預設對話性格中選擇,包括預設(Default)、專業(Professional)、友善(Friendly)、坦率(Candid)、怪趣(Quirky)、有效率(Efficient)、極客(Nerdy)及憤世嫉俗(Cynical),滿足不同使用場景的需求。無論使用者需要專業嚴謹的商務對話,抑或輕鬆愉快的日常互動,都能找到相應的性格設定。 更進一步,OpenAI推出了實驗性功能,允許使用者直接從設定中微調ChatGPT的風格,讓AI助手能更精確地符合個人偏好。這項功能已於本週開始向部分使用者推出,標誌著AI個性化程度又向前邁進了一大步。此外,使用者在設定中進行的個性化調整現在可以即時生效於所有對話,包括正在進行中的對話,確保互動體驗的一致性。 任務導向的雙模型設計 GPT-5.1引入了GPT-5.1 Instant與GPT-5.1 Thinking兩款升級模型,針對不同類型的任務進行最佳化,標誌著OpenAI在模型設計上的策略性轉變。GPT-5.1 Instant專注於快速反應,優先考慮速度與對話流暢度,適合日常問答、集思廣益或文章摘要等場景。該模型因重新設計而變得更加平易近人,在處理簡單問題時能迅速回應。 相比之下,GPT-5.1 Thinking則採用與推理模型相同的技術堆疊,針對事實準確性和解決複雜問題的表現優於前代GPT-5。這款模型在回應時會自動調整思考時間,對複雜問題投入更多思考,而對簡單問題則快速回應,提供了更聰慧的時間分配策略。GPT-5.1 Thinking的回應也變得更清晰,減少了專業術語和未定義詞彙的使用,使這款最強大的模型更易於理解和使用。 在多數情況下,ChatGPT系統會自動為使用者的提問配對至最合適的模型,簡化了操作流程,使用者無需在速度和深度之間手動權衡。付費使用者仍可透過模型選擇器主動選擇「GPT-5.1 Thinking」,或在提示中輸入類似「認真思考這個問題」的指令,確保在生成回應時充分發揮推理功能。 技術水平的持續躍進 在技術層面上,GPT-5.1相較於前代版本展現出多項顯著改進。新版本在事實準確性方面表現更佳,能夠更有效地減少虛構資訊,提供更可靠的回應。GPT-5.1對使用者指令的遵循能力也得到強化,這意味著使用者能更精確地控制AI輸出結果的格式、語氣與內容。 此外,GPT-5.1新增的自訂指令功能讓使用者享有更強大的控制權,可以透過設定來微調ChatGPT的行為和語調。這些個性化設定最初支援文本聊天,後續將擴展至語音功能,使使用者無需編寫複雜的自訂提示,就能調整ChatGPT的互動方式。 全球超過8億使用者推動的演進 OpenAI認為,隨著全球已有超過8億人使用ChatGPT,「一體適用」的時代已經過去。因此,GPT-5.1的設計理念是將AI助理從單一角色升級為能夠匹配使用者個人需求的多樣化人設。這一策略性轉變反映了OpenAI對市場需求的深刻理解,以及在AI競賽中超前佈局以「使用者體驗」為核心的決心。 升級推出計劃 新版本GPT-5.1已於本週開始向ChatGPT使用者陸續推出,優先向付費使用者提供。舊版GPT-5模型將移至ChatGPT清單中的「舊版模型」部分,保留3個月後將下架,給予使用者充足的過渡時間。...

OpenAI於2025年舉行的Dev Day大會揭示了ChatGPT進入全新「應用程式時代」的戰略轉型,展現其從單一語言模型向多模態平台的躍進。這場開發者盛會帶來多項創新版圖,不但讓ChatGPT成為所有應用程式的聚合中心,亦揭示了OpenAI未來在硬體領域的佈局,為香港與台灣的用戶提供更強大且多元的AI服務體驗。 首先,這次的最大亮點是ChatGPT內建Apps SDK的發布。這個開發框架使得開發者得以直接在ChatGPT內構建各種應用程式,用戶不必跳出對話視窗就能完成多元工作。例如,用戶可以直接在聊天中使用Canva設計海報、透過Spotify建立音樂播放清單、在Booking.com訂購飯店,甚至透過Coursera學習線上課程,實現前所未有的無縫整合和交互體驗。此舉類似微信小程序當年讓生態活絡的模式,標誌著ChatGPT正朝向AI作業系統(AI OS)的方向演進,未來的ChatGPT不僅是聊天工具,更像是一個全方位智慧助理平台。 再者,OpenAI推出了Agent Kit,一套為打造生產級智能體(Agent)而設的開發套件。這個工具助力開發者創造自動化、高度適應性及個人化的智能任務代理,增強工作流程的靈活性與效率。現場展示案例包括Albertson超市和HubSpot等大企業利用Agent Kit快速部署智能體,優化客服與營銷等環節。 在模型與API方面,OpenAI也不斷進化。最新推出的GPT-5 Pro API被定位為在精準度極其重要的任務中使用的頂尖模型,同時伴隨更新的Sora 2多模態視頻生成API,能將影片創作融入App內,為創作者帶來全新玩法。此外,OpenAI發表了成本大幅下降的語音與圖像微型模型—gpt-realtime-mini與gpt-image-1-mini,分別較大型模型便宜70%及80%,此舉令AI整合方案更趨經濟且普及。 硬體方面,OpenAI與Broadcom合作推動10 GW訂製晶片計畫,這將助力AI基礎設施提升運算效能,挑戰市場既有龍頭Nvidia的地位。這種自製晶片策略,可望為ChatGPT和Sora等應用注入更強效能與穩定性,為未來的AI硬體生態打下基礎。 值得一提的是,OpenAI在會中也發表了名為ChatGPT Pulse的手機新功能,讓ChatGPT能主動進行研究與追蹤個人化資訊。系統每日根據用戶的聊天歷史、反饋及連結的日曆、郵件等應用,提供專屬的主題視覺卡片,推送貼合用戶需求的更新內容,如即時建議、待辦事項或餐飲推薦,為用戶帶來更加主動且貼心的助理體驗。 從整體來看,OpenAI Dev Day 2025的發布內容不只是功能升級,更像是AI平台的全面革新。它將ChatGPT打造為一個開放且多元的應用生態,不僅擁有強大的語言理解與生成能力,還擁有整合影像、影片、聲音、以及第三方服務的多模態交互能力。對於以香港及台灣為目標市場的用戶而言,這意味著未來能在日常工作與生活中享受更沉浸且高效的智能助手,同時發揮在地創意與需求,搭建更多符合華語市場特色的AI應用。 綜合以上,OpenAI的這次開發者大會揭示了AI技術的下一波革命,從核心的模型訓練,轉向平台與生態建設,同時著眼於硬體的持續優化,形成全鏈條的競爭能力。隨著ChatGPT App時代的正式開啟,AI不再是單一工具,而是全面融入多樣化生活和產業場景的智能操作系統,為用戶帶來更智慧且多元的服務。 #OpenAI #ChatGPT...