人工智慧進展在 2025 年後仍然持續加速,卻與「AI 已經見頂」的輿論形成鮮明對比。這種人工智慧進展與悲觀敘事之間的落差,如果被誤讀,企業與個人都可能在未來幾年錯失最關鍵的佈局窗口。

在觀察近年的大型語言模型與多模態模型表現時,一個愈來愈清楚的訊號是:AI 在「智力」層面的進步,並沒有停下腳步,反而以近乎線性的節奏穩步向前。真正改變的,是我們對「突破」的期待與感受門檻,而不是技術曲線本身。

AI 進展真的放緩了嗎?量化指標給出不同答案

若單純從話題熱度、估值泡沫、或單一產品的發布節奏來看,確實很容易得出「AI 進展變慢」的錯覺。但若改用量化指標檢視,例如以人類智商題型為靶心的標準化測試,故事就完全不同了。

以過去一年多的數據來看:

- 領先模型在類 IQ 測試中的分數,從人類水準的中低段,穩定攀升到明顯的高智商區間

- 進步不是偶發性的巨大跳躍,而是每個月持續的小幅成長

- 單看趨勢線,大約相當於每月增加數個 IQ 點的「智力增量」

這代表什麼?代表 AI 智力並沒有停滯,而是在一個我們肉眼不容易察覺、卻對長期影響極深的線性坡度上持續上升。人類對變化的體感,往往只對「大版本更新」敏感,卻忽略了這些版本之間,模型在看不見的測試集上其實一直在緩步變強。

用 IQ 測試觀察人工智慧進展:線性成長的清晰訊號

若把 AI 放進標準化智商題型裡,會看到幾個耐人尋味的現象。

1. 封閉測試:真正排除訓練資料污染的進步曲線

所謂「離線」或封閉式的 IQ 測試,是指題目事先不公開、也不出現在網路上,盡可能避免被收錄進訓練資料。這類測試更接近在考 AI 的「真本事」,而不是記憶或網路搜尋能力。

在這類離線測試中:

- 領先模型的分數,從早期接近人類平均甚至偏低的水準,一路上升到相當於理工科大學生的智商區間

- 整體走勢近乎線性,而非逐漸趨於平台

- 截至 2025 年底,曲線仍看不到明顯的飽和跡象

這種線性成長的特徵,非常關鍵。它暗示我們:在現有架構、現有方法論之下,仍有大量可挖掘的效能空間。也就是說,還沒到「只靠堆更多算力也不再變聰明」的瓶頸。

2. 公開智商測驗:頂級模型已逼近滿分

相較之下,在部分公開、題目容易在網路上找到的智商測驗中,最強模型已經幾乎「打穿」天花板,分數接近滿分上限。這顯示出:

- 當題目可能出現在訓練資料裡時,模型的表現會被放大

- 這不代表 AI 真正具備那樣高的通用智力,但證明其對常見模式的掌握已極為成熟

因此,若要判斷真正的人工智慧進展,必須同時看封閉測試與公開測試,並意識到資料污染與提示設計的影響。兩者加總起來的訊號是:AI 在抽象推理與邏輯模式識別上的能力,持續朝高端人類水準逼近。

視覺型 AI 的突破:從「幾乎瞎眼」到逼近人類平均

更值得注意的是多模態與視覺推理的進展。早在 2024 年初,把純圖像式的智商圖形題直接丟給當時的主流模型,結果往往接近隨機亂猜,等同於人類智商 60 多分的水準。研究者只好改成用文字描述圖片,讓模型在「文字世界」中作答。

短短一年多後,情勢出現翻轉:

- 新一代多模態模型,能直接看圖作答,不再需要文字解釋

- 在視覺版智商測試中的分數,已逼近甚至略高於人類平均

- 雖然在更困難的視覺題上,仍明顯落後於自身的文字推理能力,但進步軌跡依舊趨近線性

有趣的是,不同模型在「純推理」與「視覺理解」之間的長短板差異開始浮現:

- 有些模型在抽象推理題上領先群雄,卻在視覺題上表現平平,等同「高智商但幾乎色盲」

- 另一些模型則在視覺題上取得關鍵突破,成為真正意義上的多模態通才

從產業角度看,這種多樣性反而是好事。它意味著競爭者會在不同維度上互相牽制,也為下游應用提供更多「專長風格」截然不同的模型可選。

為何「線性 AI 智商成長」是被低估的大消息?

多數人提到 AI 未來時,不是想像指數爆炸的奇點,就是想像突然停滯的泡沫。線性成長不性感、也難上頭條,卻往往是最有預測力的訊號。

如果領先模型在封閉測試上的「智商」平均每月提升數個 IQ 點,持續兩三年,意味著幾件事:

- 可預期的壓力與機會

產業不會在一夜之間被摧毀,但每年都會面臨實質再洗牌。 - 產品與工作流會以「階梯式」重構

不同於一次性的大毀滅,而是每隔一年工作內容就被改寫一輪。 - 政策與治理有時間反應,但不能再拖延

線性並不等於緩慢,而是有足夠訊號可以提早調整教育、勞動與監管框架。

很多人害怕的是「突然的超級智能」,但真正值得擔心的,也許是這種穩定而無情的線性爬升:當你終於感覺到壓力時,其實已經落後好幾個「智商階層」。

未來兩到三年:AI 補位人類,而非全面取代

從智商測試與實務經驗來看,在至少未來兩到三年,多數知識與創意工作者,會先體驗到的是「補位」而非「取代」。

這段期間的典型變化包括:

- 工作內容重心改變

從「親自產出每一行內容與程式碼」,轉向「設計問題、審核結果、組裝流程」。 - 職務標準抬升

中位數表現被 AI 拉高,真正突出的價值將來自結合領域知識、人際溝通與系統思維的能力。 - 個人與團隊差距擴大

懂得駕馭 AI 工具的人,輸出速度與品質將遠遠甩開拒用或不熟練者。

真正全面性的「替代效應」,比較可能出現在 AI 能同時滿足三個條件時:

- 智商型測試全面超越人類頂尖群體

- 視覺、語音、操作環境等多模態感知與行動能力成熟

- 在實體世界或數位基礎設施中,擁有足夠的執行代理權

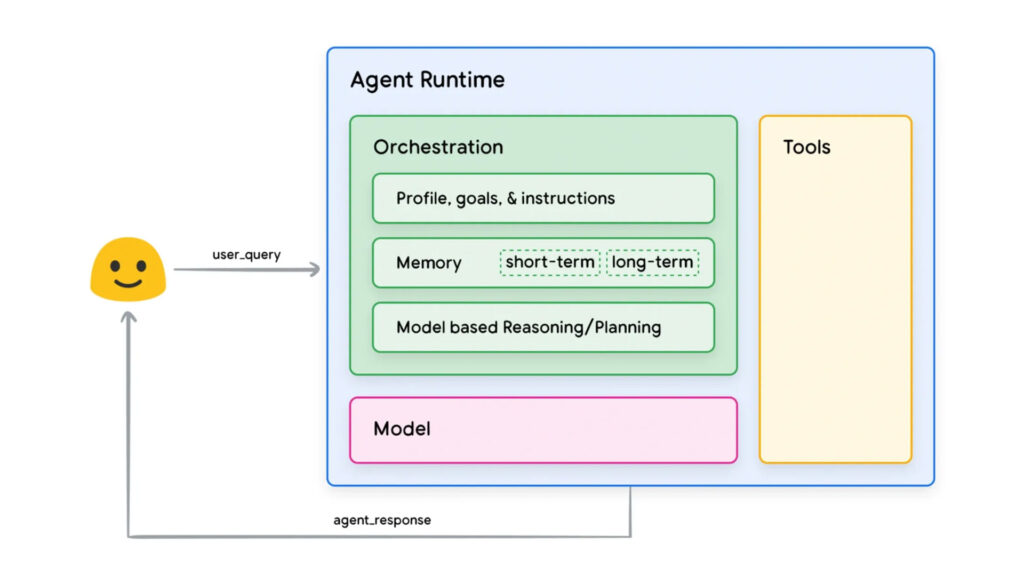

目前,AI 在第一點快速接近,第二點穩定前進,第三點則仍高度受人類與制度限制。這就是為何中期風險更多來自「大量行業的結構性重新分工」,而非立即性的全面失控。

風險與安全:極端悲觀與盲目樂觀之間的中間路線

在 AI 安全與治理的討論上,兩種極端觀點最容易吸睛:

- 「AI 很快就會毀滅人類」

- 「AI 只是工具,風險被誇大」

然而從當前的進展節奏來看,更符合現實的是一條中間路線:

- 承認 AI 智力確實快速提升,長期風險不容忽視

- 同時也看到技術尚未形成全面自主的行動能力,仍有時間強化安全機制與監管架構

- 倚賴模型多元競爭與相互制衡,降低單一系統失控的系統性風險

這不意味著可以鬆懈,反而意味著「現在就該動手」,因為還來得及建立更安全的設計與治理慣例,而不是等到真正出現不可逆的超級智能再後悔。

企業與個人現在應該做什麼?三個實際行動方向

面對持續線性的人工智慧進展,最糟糕的策略是「觀望」。不論你是企業決策者或個人工作者,都可以從以下幾點開始著手:

1. 將 AI 納入核心流程,而非邊角實驗

- 選擇一到兩條最關鍵的業務流程,刻意導入生成式 AI 與自動化工具

- 量化比較導入前後的效率、品質與風險,建立「AI 投資報表」

- 避免只在行銷文案或簡單客服這種邊陲領域試水溫

2. 訓練團隊的「AI 素養」而非單點專家

- 讓所有關鍵職能都具備基本提示工程、驗證與錯誤校正能力

- 建立內部最佳實務與提示範本庫,讓經驗能在組織內快速擴散

- 將 AI 工具視為「團隊共用的大腦延伸」,而非少數工程師的玩具

3. 為更高階的自動化預先設計「安全欄杆」

- 在導入 AI 代理與自動化決策前,先定義不可逾越的安全規則

- 建立人類監督與回滾機制,確保錯誤決策可以被快速發現與修正

- 隨著模型能力提升,逐步調整授權邊界,而不是一次性全部放權

結語:把握 AI 線性成長留下的黃金窗口

當前的人工智慧進展,並非戲劇性的奇點時刻,而是穩定且持續的智力爬升。領先模型在封閉與視覺智商測試上的表現,都指向同一個結論:AI 還在加速變聰明,而且短期內看不到真正的天花板。

對企業來說,這代表未來兩到三年是一個關鍵的「黃金窗口」:早一步把 AI 內化為組織能力,就能在每一個新階段的模型升級中滾動放大優勢。對個人而言,現在投入時間培養與 AI 協作的能力,很可能就是未來十年職涯的最大槓桿。

與其糾結於「AI 會不會取代人類」,不如問自己:在接下來這段線性而無情的進步旅程裡,你是要被動適應,還是主動設計自己的位置?

#人工智慧進展 #AI趨勢 #生成式AI #科技產業 #未來工作

追蹤以下平台,獲得最新AI資訊:

Facebook: https://www.facebook.com/drjackeiwong/

Instagram: https://www.instagram.com/drjackeiwong/

Threads: https://www.threads.net/@drjackeiwong/

YouTube: https://www.youtube.com/@drjackeiwong/

Website: https://drjackeiwong.com/