人工智能(AI)已經不再只是工程師或研究人員的專利。無論你是上班族、學生、創作者,甚至只是單純對 AI 感到好奇,2026 年正是入門學 AI 的最好時機。 但問題是:👉 網上 AI 課程那麼多,新手應該從哪裡開始?👉 有沒有 不用寫程式、又免費、又講得清楚 的選擇? 以下精選 8 個真正與 AI 相關、而且適合入門新手的免費課程,涵蓋「AI 概念理解」、「生成式 AI 應用」、「ChatGPT 使用」、「AI 協作工作方式」等實用主題。 1️⃣...

蘋果 Siri 為何選擇 Gemini 而非 ChatGPT,一次看懂這場 AI 戰略轉向的真正關鍵。蘋果 AI 策略看似保守,實際上卻是在重新定義「誰才是 AI 時代的贏家」。 蘋果 Siri 選擇 Gemini 而非 ChatGPT 的核心原因 表面上,這是一場「哪個模型更強」的技術選擇,但從產業角度來看,蘋果 Siri 選擇 Gemini 而非...

AI 兒少保護的新門檻:ChatGPT 年齡預測 功能代表什麼? ChatGPT 年齡預測 功能的推出,標誌著生成式 AI 進入一個更重視兒少保護的新階段。當聊天機器人越來越像「24 小時不下線的陪伴者」,平台是否有能力分辨對方是 13 歲還是 30 歲,就不再只是產品細節,而是直接關係到未成年用戶的安全與心理健康。 在這樣的背景下,用 AI 來預測使用者年齡,並據此啟動不同強度的內容過濾與安全保護機制,已經成為大型平台不得不面對的現實選擇。 為何生成式 AI 需要「年齡預測」來保護未成年用戶? 生成式 AI 的對話能力愈來愈強,孩子在深夜與 ChatGPT...

ChatGPT 校園授權正以驚人速度改變美國高等教育的版圖,OpenAI 則在背後推動一場安靜卻激烈的「校園 AI 土地爭奪戰」。在短時間內,越來越多美國公立大學選擇直接大規模購買 ChatGPT 授權,把生成式 AI 當成和校園郵件、線上學習平台一樣的「標準基礎設施」。 這不只是一筆軟體採購,而是關於: – 誰能主導未來知識工作者的工具習慣 – 誰能在學生還沒畢業前就鎖定他們的數位生態系 – 誰能把生成式 AI 變成下一代「Office 等級」的必備服務 低價策略:OpenAI 如何打開校園大門 在美國大學市場,價格策略是 ChatGPT 校園授權成功的關鍵之一。與其專注於單一用戶高單價,OpenAI...

Google Disco 是一款以 Gemini 為核心的瀏覽器 AI 工具,主打「從瀏覽器分頁直接生成 Web App」。這不只是又一個聊天機器人,而是嘗試改寫我們與瀏覽器、甚至與應用程式本身互動的方式。 在過去,我們開了十幾個分頁、複製貼上內容、再到各種工具裡整理;未來,Disco 的目標是:讓這些分頁本身,直接「長」成一個協助你完成任務的互動式應用。 從「看網頁」到「做應用」:Disco 的核心思維 傳統瀏覽器的角色是資訊入口,AI 搜尋或對話助手頂多是「更聰明的搜尋列」。Disco 的思維則更激進: 不只理解你現在看的頁面 還要理解你整個瀏覽脈絡 然後主動把這些內容,組裝成一個可以操作的 Web App 這代表一個重要轉變: 使用者從「被動吸收資訊」變成「透過生成應用來操縱資訊」。 GenTabs:從瀏覽器分頁長出的...

OpenAI 認證正成為企業縮短 AI 技能差距的關鍵工具。面對生成式 AI 的爆炸性成長,OpenAI 推出全新的 AI 認證標準與 AI Foundations 認證課程,目標是在 2030 年前為 1,000 萬名美國勞工建立可驗證的 AI 能力,正面迎戰「AI 技能差距」問題。 為何 OpenAI 要用認證來解決 AI 技能差距?...

AI 自動化工作正在加速改變白領職場,也正在重塑「哪種工作最容易被 AI 取代」的順位。當 OpenAI 高層公開點名三大產業正站在 AI 自動化工作的最前線時,所有上班族都應該重新檢視自己的職涯風險與機會。 本文整理這位 OpenAI 商業產品負責人在節目中的核心觀點,說明為何生命科學、客戶服務與電腦工程三大領域最容易被 AI 自動化,同時提供實用的轉型方向,讓你在 AI 取代工作的浪潮中仍能穩住職涯、提升價值。 什麼是「AI 自動化工作」?為什麼白領要特別小心? 簡單來說,AI 自動化工作就是把原本由人類完成的重複性、可標準化、以電腦為主的知識型工作,交給人工智慧系統處理。這類工作往往有幾個共同特徵: 大量時間花在蒐集、整理、比對資料 任務有明確規則與標準流程 結果可以用數據衡量與優化 幾乎完全在電腦與網路環境中完成 因此,過去大家以為比較安全的白領辦公室工作,現在反而成為...

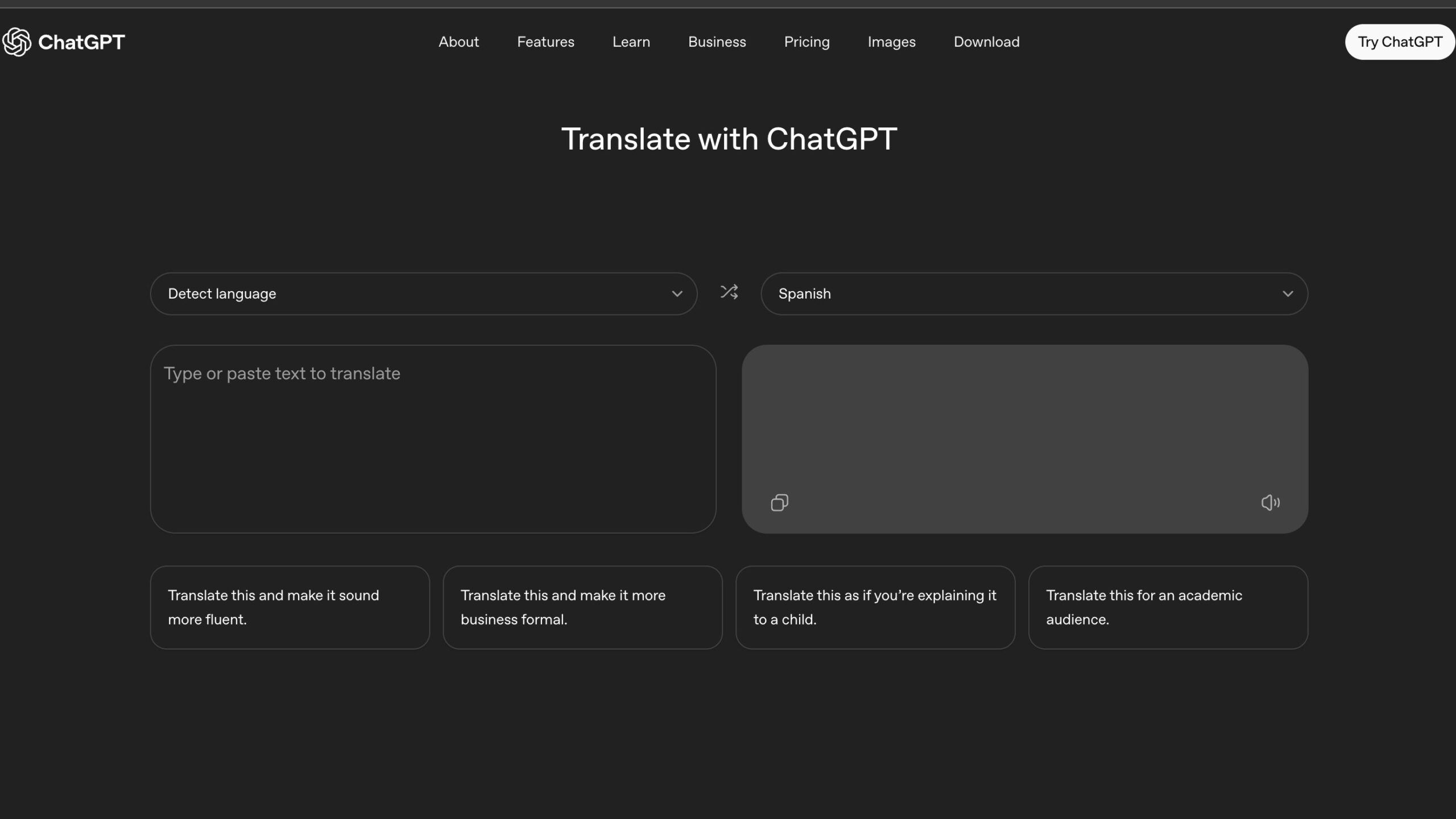

ChatGPT 翻譯正在改寫我們對線上翻譯工具的想像。隨著 ChatGPT Translate 正式成為獨立翻譯服務,它也被清楚地放在與 Google 翻譯正面對決的位置上。 ChatGPT Translate 是什麼?介面與基本功能 從使用者角度看,ChatGPT Translate 極其直覺: 左邊輸入框:輸入或貼上原文 右邊輸出框:顯示目標語言翻譯 自動偵測語言:大多數情況下不需手動選擇來源語言 支援超過 50 種語言的雙向翻譯 在桌面瀏覽器上,目前核心是純文字翻譯;若改用手機瀏覽器開啟,則可直接用麥克風說話,由系統先語音轉文字,再進行翻譯。這些元素都十分「Google 翻譯式」──快速、直接、零門檻。 真正有趣的地方,發生在翻譯完成之後。 與 Google...

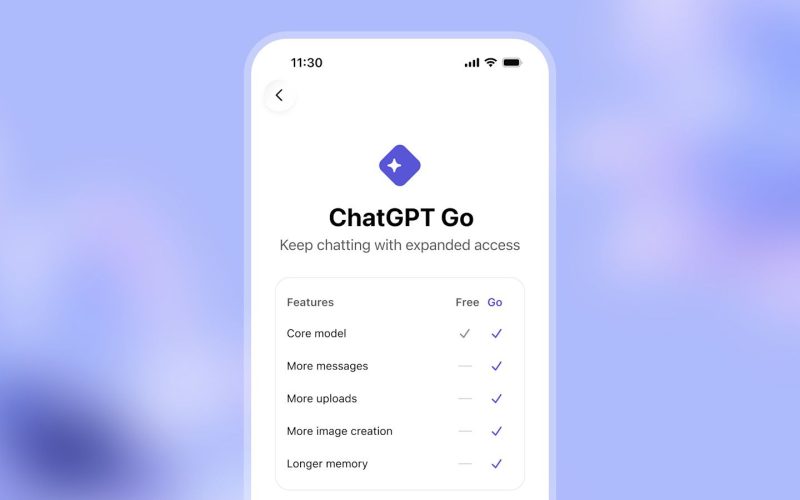

OpenAI 最新推出的 ChatGPT Go 訂閱方案已 全球上線,旨在讓更多用戶以更低成本體驗進階 AI 功能。這對希望提升工作效率、內容創作及學習生產力的你來說,是 2026 年不可忽視的 AI 趨勢。 📌 什麼是 ChatGPT Go? ChatGPT Go 是 OpenAI 推出的 低價付費訂閱方案,定位介於免費版與 Plus(每月約 $20...

在生成式AI 競賽中,OpenAI 正把「企業AI」當成與 Google 等巨頭正面對決的主戰場。最新數據顯示,OpenAI 的 ChatGPT Enterprise 與 API 使用量在過去一年大幅飆升,成為其市場策略的關鍵核心,尤其是在面對 Google Gemini 等強勢競爭時。 本文將拆解 OpenAI 這波企業AI 佈局的關鍵數據、產品策略與風險,並給出企業決策者可直接採用的行動建議。 一、OpenAI 企業AI 成長關鍵數據總整理 先看這波 OpenAI 企業AI...

Google Gemini 驅動蘋果 Siri 與 AI 功能,代表行動裝置與生成式 AI 進入了一個全新的權力分配時代。當兩大科技巨頭在 AI 模型與終端生態系上開始深度綁定,不只是 Siri 的未來被改寫,整個智慧手機與雲端 AI 市場的版圖也將被迫重新排列。 在這場合作之後,「誰擁有使用者」、「誰擁有模型」、「誰掌控預設入口」這三個問題,不再有單一贏家,而是進入更複雜的共生、博弈與監管新局。 Google Gemini 驅動蘋果 AI 功能的關鍵意義 長期以來,蘋果以垂直整合著稱:自家晶片、自家作業系統、自家應用商店,連隱私政策與安全標準都盡量掌握在自己手裡。如今選擇讓 Google Gemini...

未來20年內,Elon Musk 預測人工智慧(AI)與機器人技術將徹底改變工作與經濟結構,使得工作成為「選擇性」且貨幣變得「無關緊要」。這一預測引發廣泛討論,尤其針對年輕世代的職涯發展及社會運作模式產生深遠影響。 Elon Musk 在2025年美國-沙烏地阿拉伯投資論壇上,明確表達他認為AI和機器人將在10至20年間廣泛整合於企業和工作流程中,極大提升生產力和效率。這種技術發展將使大部分工作自動化,人類不再必須以工作為生,而是可以選擇是否從事任務。因此,工作不再是賴以維生的唯一途徑,而變成一種自願的活動,生活不再依賴勞動收入。 Musk 進一步指出,隨著AI智能和機器人技術持續進步,貨幣的角色可能會逐漸消失。他引用科幻小說作家Iain M. Banks 的《Culture》系列,其中描繪一個超智能AI系統普及後,財富和傳統貨幣不復存在的社會形態。他認為未來社會可能不再使用金錢作為交換媒介,而生活需求將由系統自動供應,減少貨幣需求。去年,Musk 也曾提及普遍基本收入(universal basic income)的概念,表示政府可透過這種制度,保證市民基本生活所需,即使工作變得不必要。 不過,這樣的未來圖景也帶來挑戰。Anthropic執行長Dario Amodei 表示,AI有可能在未來削減多達50%的白領基層職位,對年輕世代造成就業困境。若大部分工作崗位消失,年輕人的工作機會將受到嚴重壓縮,如何保障社會穩定與個人自我價值實現,將成為核心議題。有人擔憂若工作與收入同時消失,會導致社會不安和個人生活意義的缺失。 此外,AI普及對經濟及政治結構也可能產生巨變。當貨幣失去中心地位,政府財政政策和傳統經濟激勵機制將面臨考驗,如何調節資源分配和維持社會秩序,成為政策制定者必須面對的新課題。社會價值觀也可能轉向更重視幸福感、創造力和自我實現等非物質層面,重新定義人與工作、金錢的關係。 放眼亞洲市場,尤其是香港及台灣,兩地經濟結構中金融和科技產業占比高,AI及自動化的發展尤其受到重視。未來勞動市場將如Elon Musk所言,趨向高效率且工時選擇性強的模式,人工取代性大,但同時也將創造出新興行業和技能需求。例如AI維護、數據分析、創意設計及人機協作等領域,或成為明日職場的新藍海。教育和職涯培訓也必須跟上節奏,強化跨領域能力與創新思維,應對工作形態的急速演變。 綜合來看,Elon Musk的前瞻性預測表明,隨著AI和機器人技術的突破,未來工作將不再是必須,貨幣的地位或將衰減,社會將步入一個全新而充滿挑戰的階段。對普通人而言,如何適應這種變革、發展自我價值和尋求生活意義,將是未來兩岸三地社會不可忽視的課題。 #人工智慧 #工作變革...